O objetivo deste artigo é ensinar alguns princípios de fotografia para fotógrafos amadores. Celulares atuais possuem câmeras fotográficas que permitem que um leigo, mesmo sem conhecimentos de fotografia, tire fotos de qualidade bastante boa. A capacidade de processamento dos celulares permite que a imagem seja analisada e processada de modo a ajustar a exposição e efetuar correções necessárias para obter-se uma boa foto. Uma câmera semiprofissional ou profissional permite que o fotógrafo tenha total controle sobre o resultado. Assim, se você possui uma boa câmera e pretende fugir do ajuste automático, este tutorial é para você. Uma câmera fotográfica, mesmo que possua um display similar à tela de um celular, possui um visor (viewfinder) que permite que se veja a imagem a ser capturada sem o inconveniente de interferências da claridade do dia ou reflexos da luz solar como ocorre nos displays de celulares. Em uma tela de celular, em um dia claro, é difícil ver-se perfeitamente a cena capturada o que dificulta a composição da cena sendo fotografada. Além do mais, uma câmera possui um sensor maior e menos sujeito a ruídos nas fotos geradas do que as de um celular, especialmente em cenas com pouca luz.

Uma canção de Beto Guedes diz em um trecho “a lição sabemos de cor, só nos resta aprender”. Quando uma pessoa decora uma lição e não a aplica, ela acaba esquecendo o que aprendeu. Se, no entanto, ela entender o que aprendeu, não esquecerá, ou, se esquecer, será fácil relembrar. Além disso, quando se entende algo, é mais fácil construir conhecimento em cima e utilizar melhor o assunto aprendido. Fotografia não é exceção. Se você entender os principais conceitos, com certeza poderá tirar fotografias melhores.

A intenção não é ser rigoroso e nem se aprofundar nos aspectos técnicos, mas sim discuti-los o suficiente para dar a base necessária para entender o que está sendo discutido.

Evidentemente não basta uma fotografia ser boa do ponto de vista técnico. Há o elemento artístico. A parte artística é mais difícil de ser aprendida (e ensinada), mas procuraremos dar algumas dicas. Além disso, existem vários depoimentos de fotógrafos experientes no YouTube sobre esse assunto. Não deixe, porém, a parte técnica estragar uma fotografia artisticamente perfeita... Alguns dos conhecimentos discutidos são de amplo conhecimento, mas é importante relembrá-los.

Refração

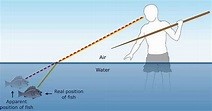

Raios de luz, quando mudam de meio, tem sua direção alterada. É o caso quando olhamos para um peixe em um lago. Nossa mente intui que a luz se propaga em uma linha reta, então, quando nossa visão recebe a luz refletida em um peixe, nosso cérebro imaginará o peixe em uma posição diferente da posição real.

Raios de luz, quando mudam de meio, tem sua direção alterada. É o caso quando olhamos para um peixe em um lago. Nossa mente intui que a luz se propaga em uma linha reta, então, quando nossa visão recebe a luz refletida em um peixe, nosso cérebro imaginará o peixe em uma posição diferente da posição real.

Luz

A luz branca, como a do Sol é composta de todas as cores que vão do vermelho ao violeta. Pela composição da atmosfera e pela forma de funcionamento de nossa visão, enxergamos o sol como amarelo, mas a luz que chega aos objetos é branca bem depois do amanhecer ou bem antes do entardecer.

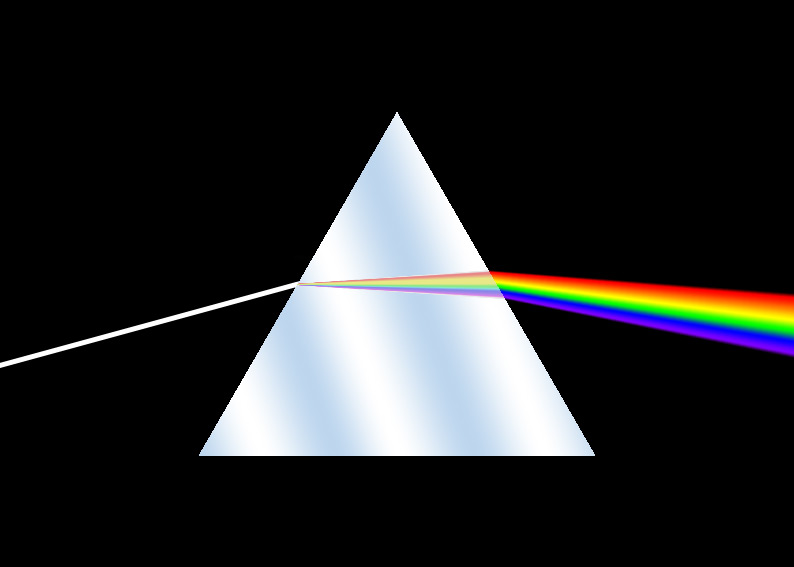

A luz é uma onda eletromagnética. Cada cor possui uma frequência diferente. A menor frequência corresponde à cor vermelha (frequências menores não são visíveis ao olho humano e são chamadas de luz infravermelha). A onda com maior frequência visível corresponde à cor violeta (frequências maiores são também invisíveis ao olho humano e são chamadas de luz ultravioleta). O índice de refração de um meio é diferente para cada frequência da onda de luz. É por este motivo que, ao atravessar, por exemplo, um prisma, a luz branca é decomposta nas várias cores do espectro visível.

A luz é uma onda eletromagnética. Cada cor possui uma frequência diferente. A menor frequência corresponde à cor vermelha (frequências menores não são visíveis ao olho humano e são chamadas de luz infravermelha). A onda com maior frequência visível corresponde à cor violeta (frequências maiores são também invisíveis ao olho humano e são chamadas de luz ultravioleta). O índice de refração de um meio é diferente para cada frequência da onda de luz. É por este motivo que, ao atravessar, por exemplo, um prisma, a luz branca é decomposta nas várias cores do espectro visível.

Lentes Convergentes

A luz, quand o atravessa uma lente, sofre refração ao entrar e ao sair da lente, pois houve mudança de meio (ar/cristal ou material de que é feita a lente).

o atravessa uma lente, sofre refração ao entrar e ao sair da lente, pois houve mudança de meio (ar/cristal ou material de que é feita a lente).

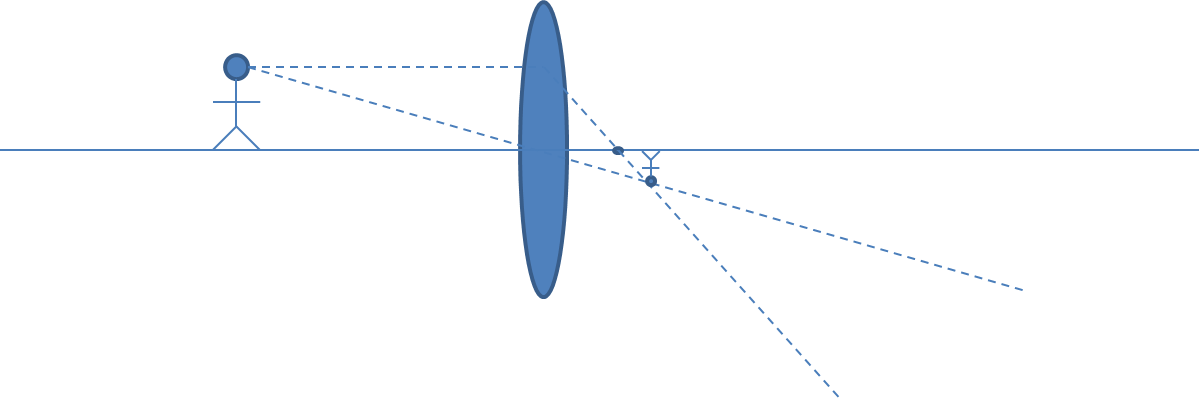

Os raios de luz que chegam a uma lente convergente paralelamente a seu eixo, ao atravessá-la irão convergir em um ponto. A distância deste ponto ao centro da lente é conhecida como distância focal e é uma característica importante de uma lente.

Os raios de luz que chegam a uma lente convergente paralelamente a seu eixo, ao atravessá-la irão convergir em um ponto. A distância deste ponto ao centro da lente é conhecida como distância focal e é uma característica importante de uma lente.

Embora exista, como vimos, a dupla refração (ar/cristal e cristal/ar) vamos simplificar, mostrando apenas o resultado final da refração nos próximos exemplos.

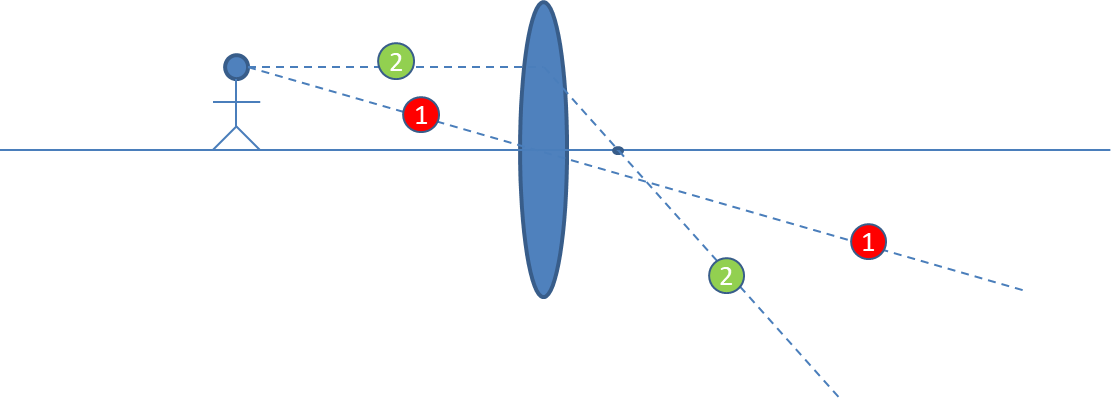

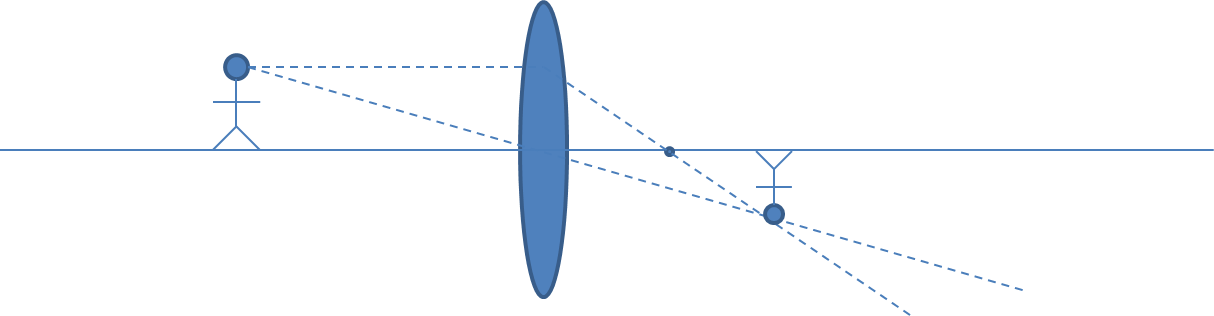

Já considerando o acima exposto, raios de luz que cruzam a região central da lente, não sofrem desvio (raio de luz 1 na figura).

Já considerando o acima exposto, raios de luz que cruzam a região central da lente, não sofrem desvio (raio de luz 1 na figura).

Da mesma forma, raios de luz que atravessam a lente paralelamente a seu eixo perpendicular, passam pelo ponto focal da lente (raio de luz 2 na figura).

Um raio genérico, entrando na lente entre o raio 1 e o raio 2 sairia da lente também entre os raios 1 e 2, mas passando pelo mesmo ponto P onde a imagem do ponto origem dos três raios de luz se formou. Este raio é identificado na figura com o número 3. O cálculo da refração deste raio ao atravessar a lente é mais complexo. Como todos os raios oriundos do mesmo ponto se cruzam em P, para efeitos de estudo podemos utilizar apenas os raios, que como os raios 1 e 2 da figura, atingem a lente perpendicularmente ou atravessam seu centro e cuja trajetória é fácil de ser determinada como vimos.

Um raio genérico, entrando na lente entre o raio 1 e o raio 2 sairia da lente também entre os raios 1 e 2, mas passando pelo mesmo ponto P onde a imagem do ponto origem dos três raios de luz se formou. Este raio é identificado na figura com o número 3. O cálculo da refração deste raio ao atravessar a lente é mais complexo. Como todos os raios oriundos do mesmo ponto se cruzam em P, para efeitos de estudo podemos utilizar apenas os raios, que como os raios 1 e 2 da figura, atingem a lente perpendicularmente ou atravessam seu centro e cuja trajetória é fácil de ser determinada como vimos.

Você deve se perguntar se não há a decomposição da luz branca similar ao que vimos no caso do prisma. Sim, existe essa decomposição, mas, pelo formato da lente, ela é menor. Para corrigir esta decomposição em máquinas fotográficas não temos apenas uma lente, mas um conjunto de lentes agrupadas. Uma das lentes desse conjunto tenta corrigir essa dispersão. Mesmo assim, ainda pode ocorrer o que se chama de aberração cromática em fotos. Esta aberração pode ser corrigida ou minimisada com softwares de edição de fotos. A aberração cromática manisfesta-se, principalmente, em arestas dividindo áreas claras e escuras em uma imagem.

Fotografia

A palavra fotografia tem a sua origem no grego a partir de phos ou photo, que significa “luz”, e graphein, que significa “desenhar” ou “registrar”. Registrar ou desenhar com a luz. A descrição não poderia ser melhor. A luz é, portanto, a principal matéria prima da fotografia. Como vimos, a luz branca, no espectro visível, pode ser decomposta do vermelho ao violeta passando por todas as tonalidades que nossa visão consegue distinguir. Quando um raio de luz branca atinge uma superfície não transparente, todas as cores do espectro são absorvidas exceto a cor característica do objeto.

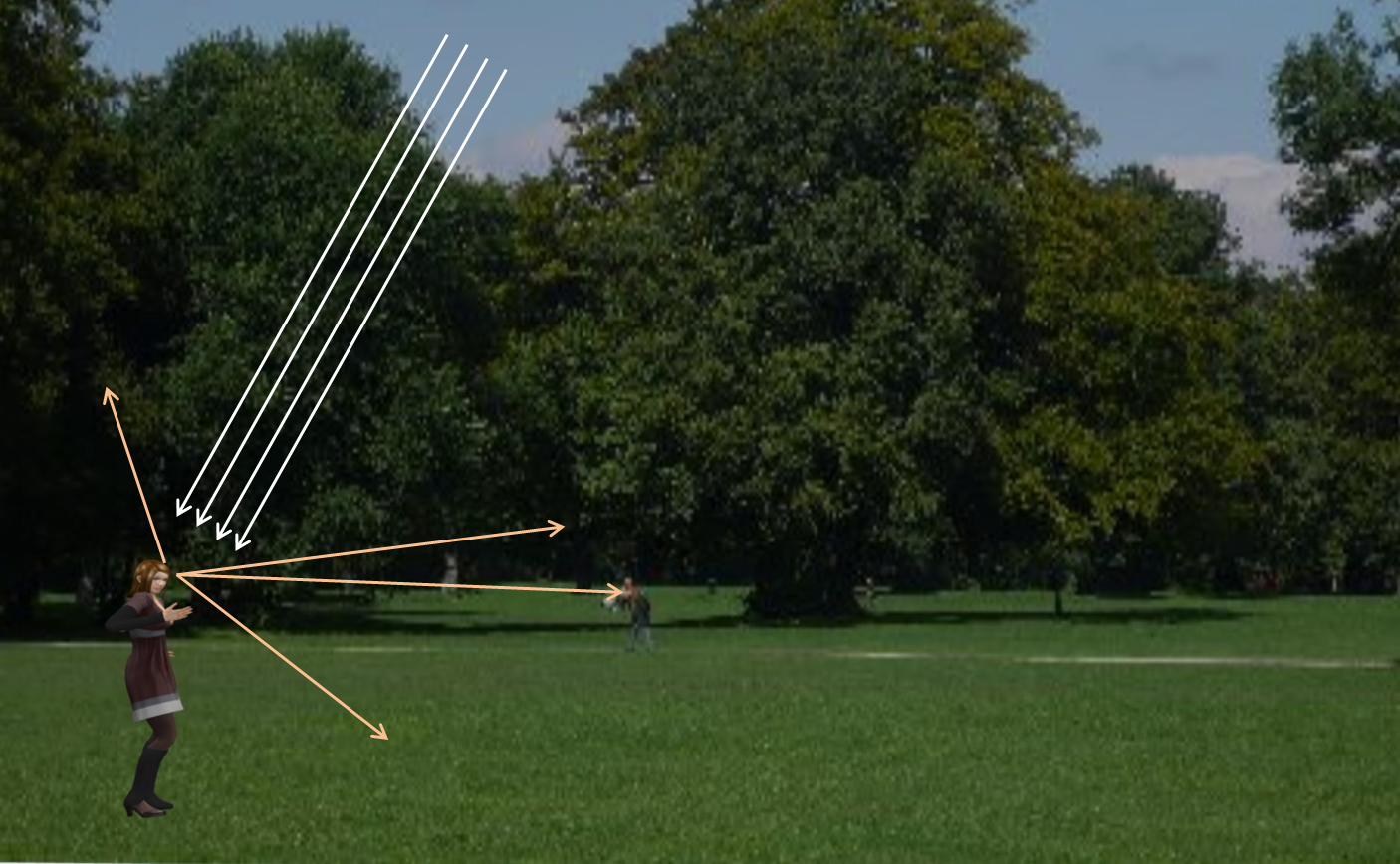

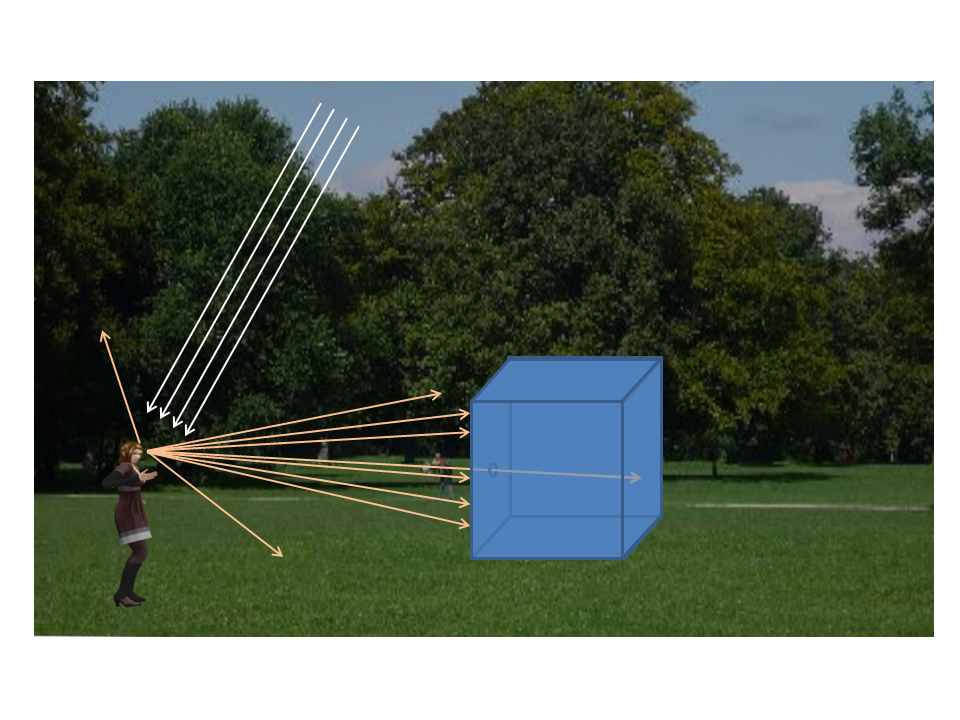

A parcela da luz não absorvida pelo objeto é refletida em todas as direções à frente do mesmo o que permite que pessoas que estejam posicionadas convenientemente o vejam.

A parcela da luz não absorvida pelo objeto é refletida em todas as direções à frente do mesmo o que permite que pessoas que estejam posicionadas convenientemente o vejam.

Vamos colocar uma caixa com um pequeno orifício em frente a uma pessoa iluminada pela luz do sol ou outra fonte de luz branca. Observe que apenas uma pequena parcela da luz refletida em um determinado ponto atravessa o orifício da caixa atingindo o fundo dela projetando um ponto com a cor refletida pelo ponto do objeto. Importante notar que nenhum outro ponto externo à caixa projetará luz sobre esse mesmo ponto do fundo da caixa.

Como isto ocorre para todos os pontos do objeto em frente à caixa, uma imagem invertida do objeto se formará na parte posterior da caixa.

Como isto ocorre para todos os pontos do objeto em frente à caixa, uma imagem invertida do objeto se formará na parte posterior da caixa.

Como a quantidade de luz que atinge o fundo da caixa para cada ponto é pequena, o objeto teria que estar muito iluminado para que a luz fosse suficiente de modo a sensibilizar um filme ou um sensor eletrônico colocado na caixa no lado oposto ao orifício.

Uma solução é colocar uma lente convergente no orifício que fará com que a imagem formada no fundo da caixa seja menor, porém, com a luz mais concentrada. Há uma desvantagem em se usar uma lente. Somente objetos situados a uma determinada distância da lente estarão em foco preciso.

Uma solução é colocar uma lente convergente no orifício que fará com que a imagem formada no fundo da caixa seja menor, porém, com a luz mais concentrada. Há uma desvantagem em se usar uma lente. Somente objetos situados a uma determinada distância da lente estarão em foco preciso.

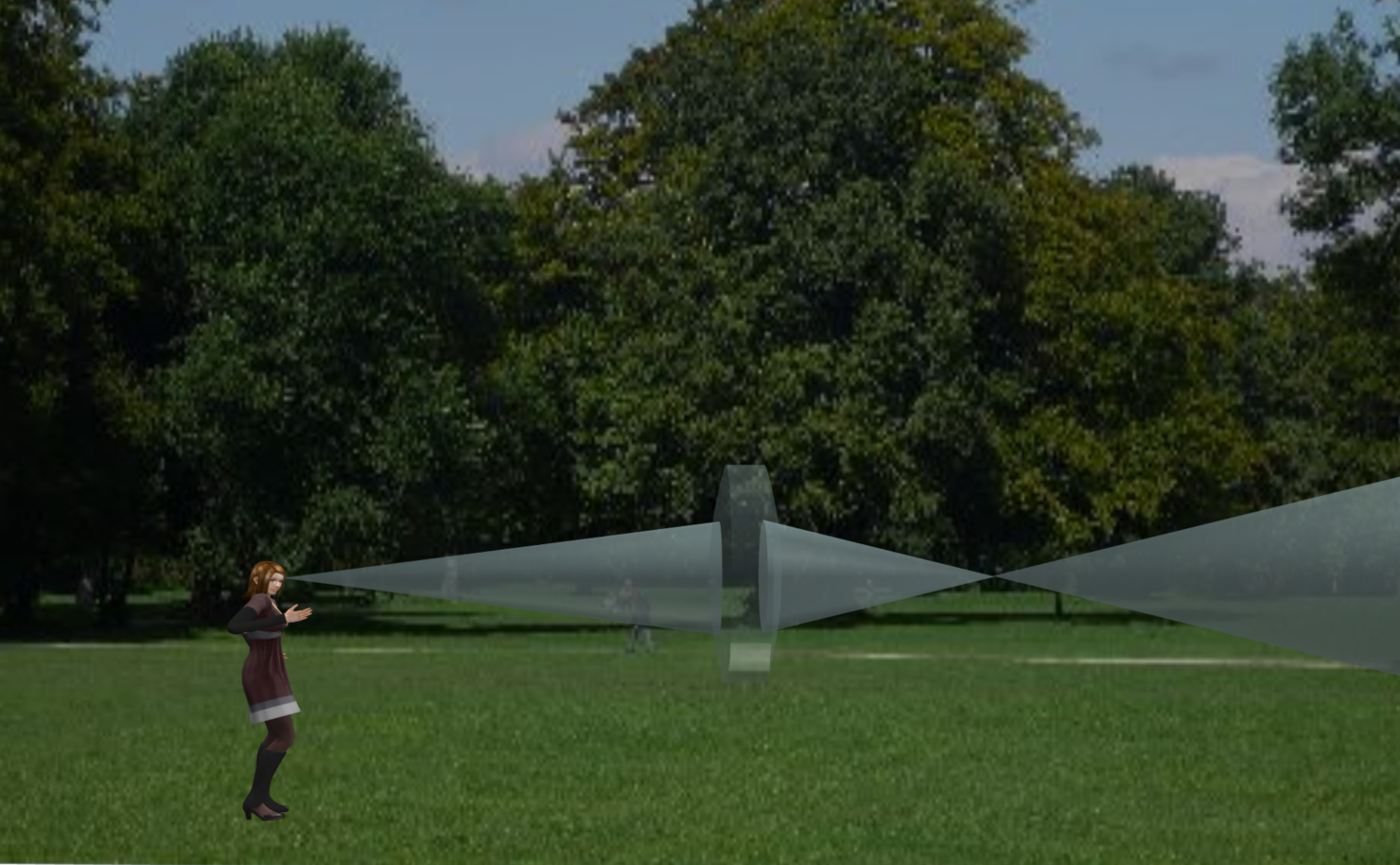

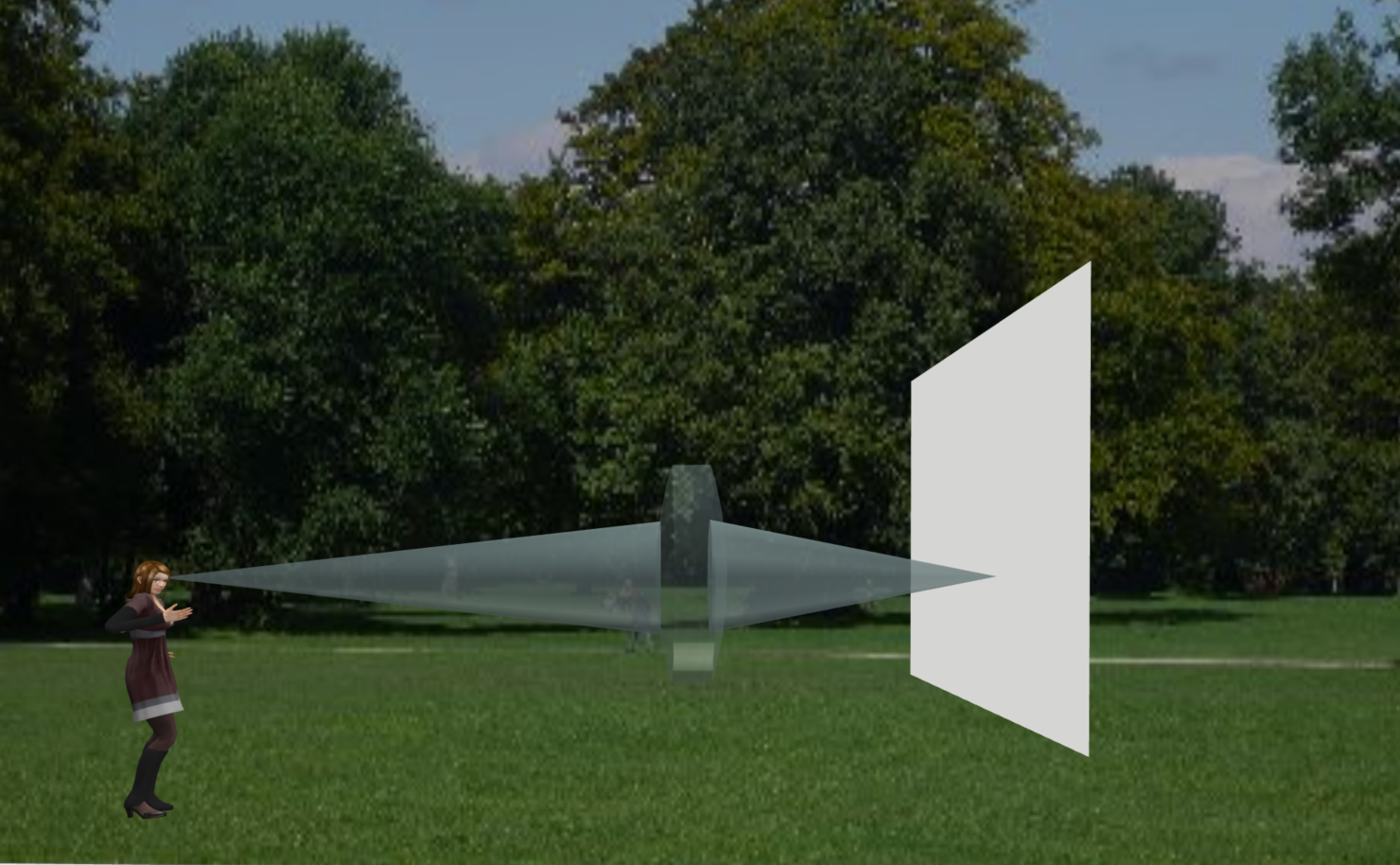

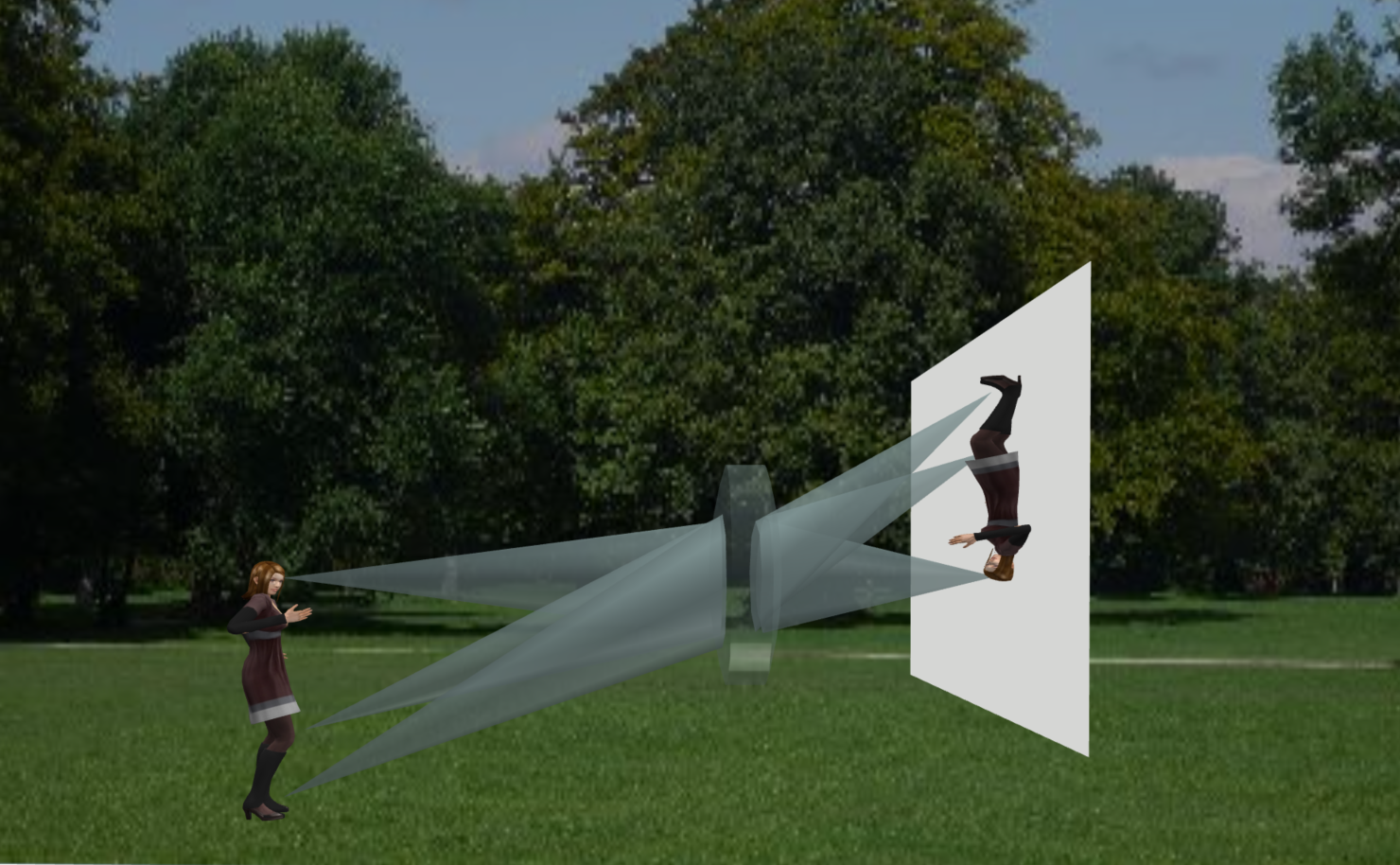

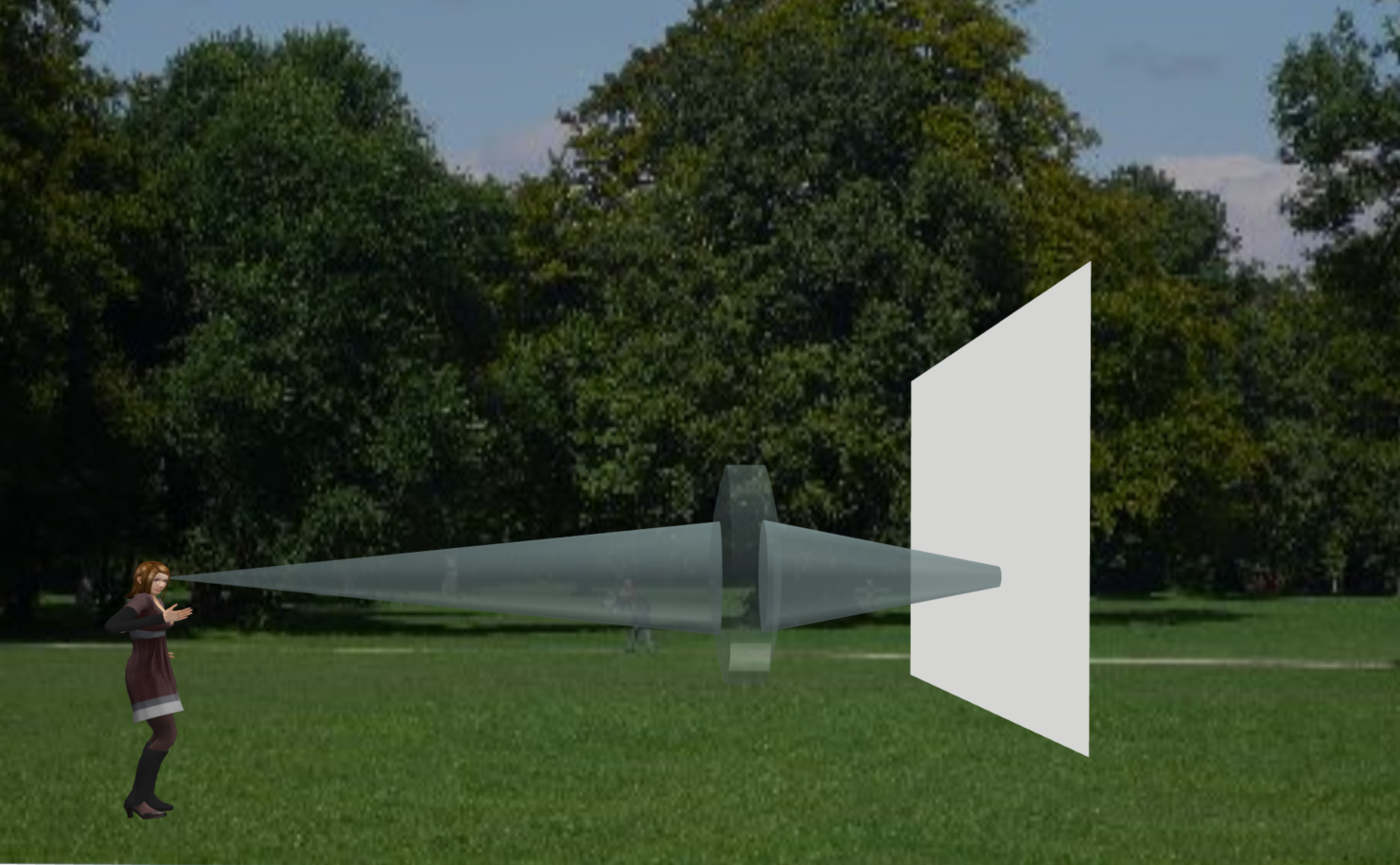

Para entender o porquê disso, vamos analisar mais detalhadamente o que ocorre quando temos um objeto à frente de uma lente convergente. Até agora, representamos lentes em corte. Para entender melhor, vamos analisar a lente em três dimensões. Tomando isto em conta, a lente à frente de um objeto receberá, de cada ponto deste objeto, raios que formarão um cone. Por exemplo, raios de luz atingindo um ponto na testa de nossa modelo chegarão à lente formando um cone de luz.

Para entender o porquê disso, vamos analisar mais detalhadamente o que ocorre quando temos um objeto à frente de uma lente convergente. Até agora, representamos lentes em corte. Para entender melhor, vamos analisar a lente em três dimensões. Tomando isto em conta, a lente à frente de um objeto receberá, de cada ponto deste objeto, raios que formarão um cone. Por exemplo, raios de luz atingindo um ponto na testa de nossa modelo chegarão à lente formando um cone de luz.

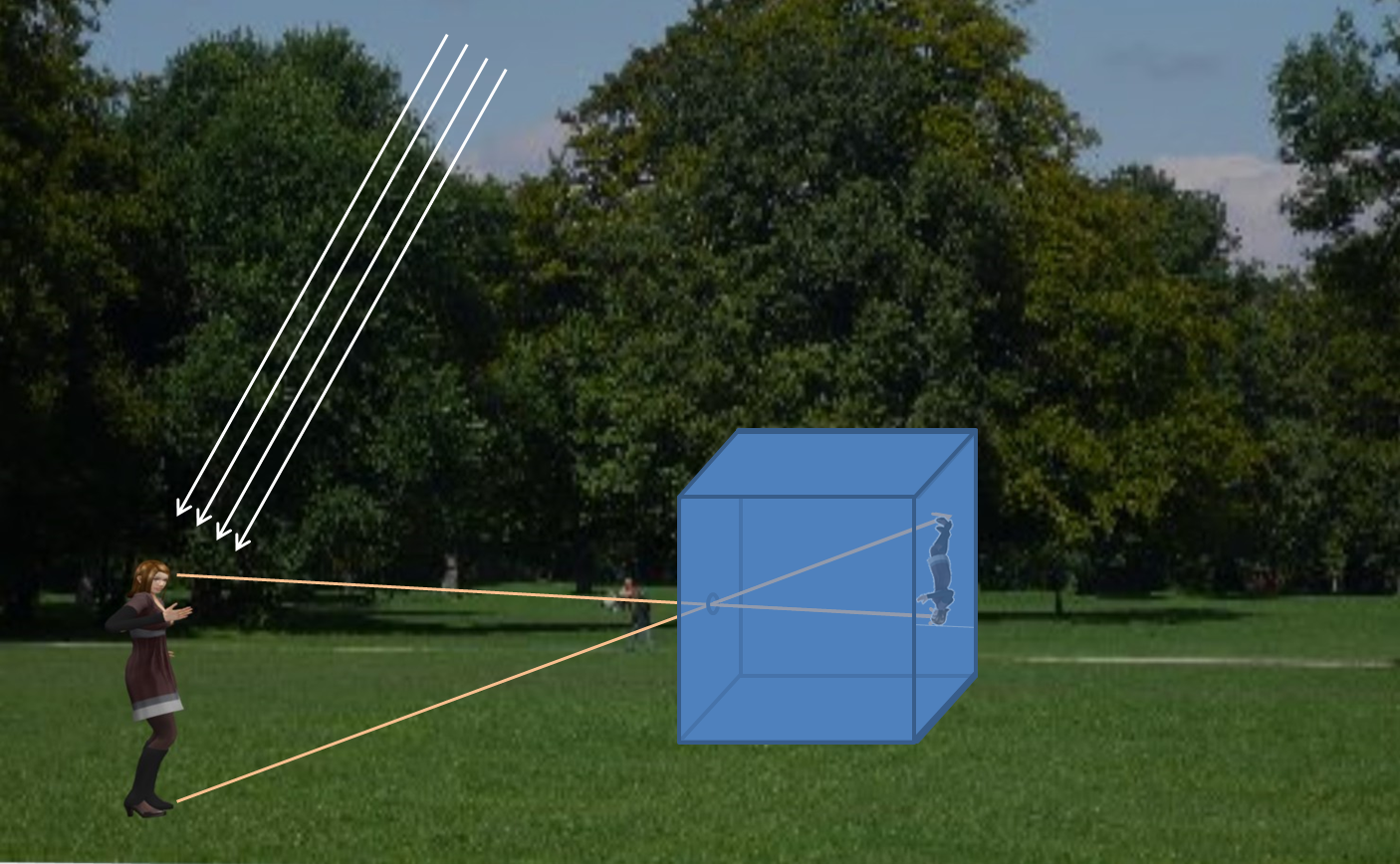

Como a lente é convergente, os raios de luz convergirão para um ponto após atravessar a lente.

Evidentemente eles não pararão aí, seguirão em frente formando um outro cone, desta vez divergente.

Se colocarmos um anteparo branco exatamente no ponto onde a luz converge, teremos, no anteparo, um ponto com a mesma cor do ponto onde a luz se originou. Na realidade este an teparo teria que estar dentro de uma caixa, como vimos há pouco, onde o único ponto de entrada de luz seria a lente. Caso isto não fosse verdade, raios de luz provenientes de outros objetos iriam também atingir o mesmo ponto que assumiria a cor resultante da combinação da cor de todos os raios de luz, provavelmente branca.

teparo teria que estar dentro de uma caixa, como vimos há pouco, onde o único ponto de entrada de luz seria a lente. Caso isto não fosse verdade, raios de luz provenientes de outros objetos iriam também atingir o mesmo ponto que assumiria a cor resultante da combinação da cor de todos os raios de luz, provavelmente branca.

Outras partes do objeto ou pessoa também receberão luz que chegará à lente formando cones com ângulos diferentes e teremos assim uma imagem invertida do objeto ou pessoa à frente da lente.

Outras partes do objeto ou pessoa também receberão luz que chegará à lente formando cones com ângulos diferentes e teremos assim uma imagem invertida do objeto ou pessoa à frente da lente.

Por enquanto vamos considerar apenas essa pessoa ou objeto.

Se a pessoa se afastar da lente o ponto de convergência de cada um dos cones cairá atrás do anteparo. Teremos então no anteparo, não pontos coloridos bem definidos, mas círculos com a cor correspondente a cada ponto e a nossa imagem estará desfocada. Para que ela esteja com foco perfeito teríamos que avançar um pouco a lente.

Se a pessoa se afastar da lente o ponto de convergência de cada um dos cones cairá atrás do anteparo. Teremos então no anteparo, não pontos coloridos bem definidos, mas círculos com a cor correspondente a cada ponto e a nossa imagem estará desfocada. Para que ela esteja com foco perfeito teríamos que avançar um pouco a lente.

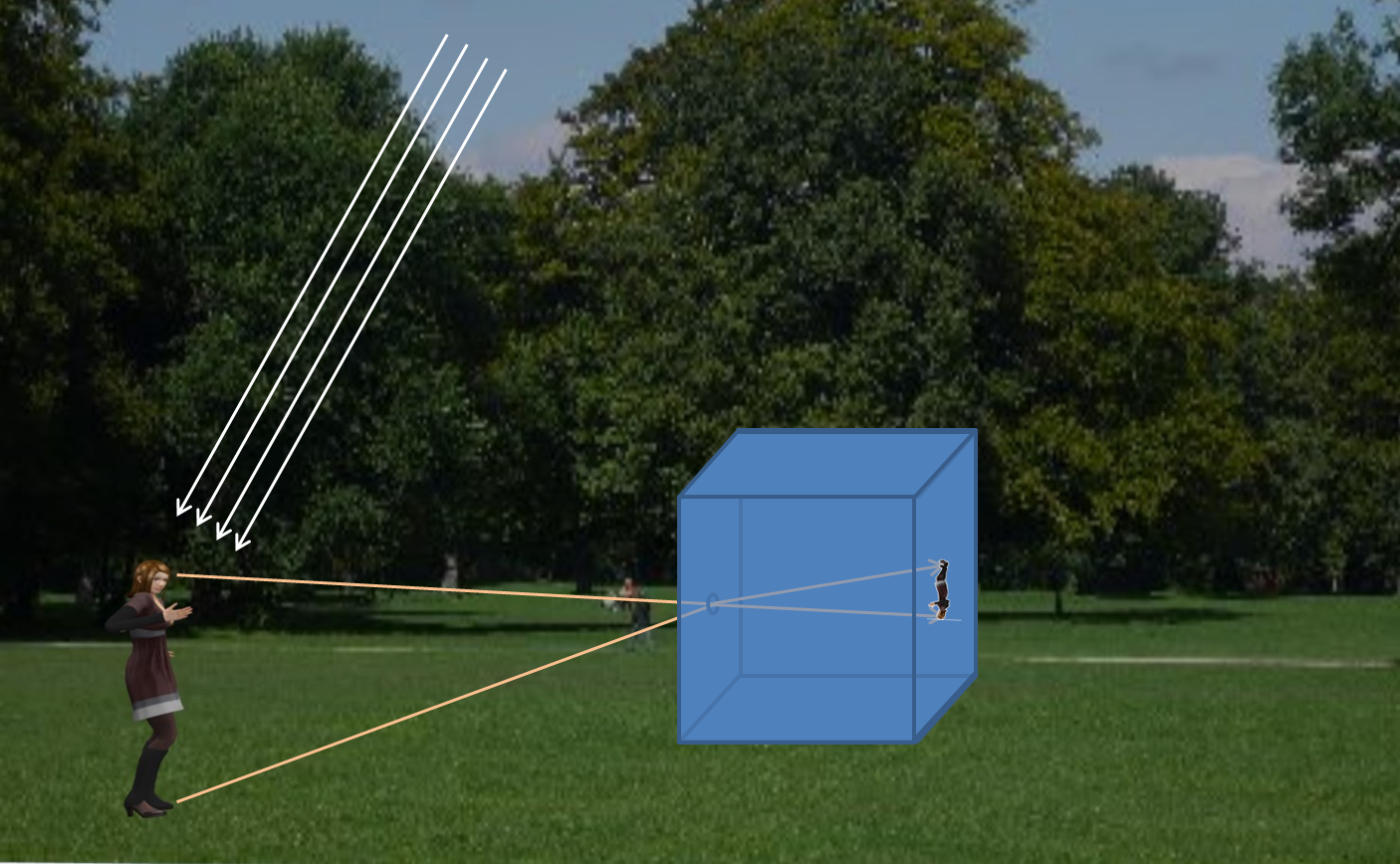

Este é um conceito importante. Para uma determinada lente em uma determinada posição em relação ao anteparo onde a imagem será projetada, apenas objetos ou pessoas que estejam em uma determinada distância da lente aparecerão em foco perfeito.

Isto pode parecer um contrassenso, porque você deve ter visto milhares de fotos onde objetos e pessoas em distâncias diferentes da câmera estão em foco perfeito.

Bem, isto não é bem verdade. Na realidade apenas aquilo que estiver na distância correta estará realmente em foco. Os demais objetos ou pessoas estarão em um foco razoavelmente aceitável. Isto por conta da incapacidade de nossa visão de detectar diferenças muito diminutas de tamanho.

Uma câmera fotográfica possui um diafragma acoplado à lente que controla a quantidade de luz que será levada ao sensor que registrará a imagem.

Em uma câmera real, o diâmetro da lente não é grande e levando-se em conta o diafragma que pode ter aberturas pequenas, os ângulos dos cones de luz são bem pequenos. Sendo assim, mesmo que o vértice do cone não esteja exatamente sobre o anteparo (no caso de uma câmera, o sensor) o círculo formado será tão pequeno que não conseguiremos distingui-lo de um ponto. Então, objetos ou pessoas que estejam um pouco antes ou depois do ponto onde há foco preciso, estarão aceitavelmente em foco no anteparo (ou sensor na câmera).

Círculo de confusão

Imagine que o objeto de sua foto esteja exatamente no ponto onde a lente projete a imagem em foco preciso. À medida que você for se afastando desse ponto para trás, por exemplo, a imagem formada por um ponto do objeto se transformará em um círculo cada vez maior com o aumento da distância. Chegará um momento em que o olho humano conseguirá perceber que não se trata mais de um ponto e sim de um círculo. Este círculo é chamado de círculo de confusão. A partir desse instante, aumentando a distância, o círculo aumentará ainda mais e não haverá mais confusão entre o círculo e o ponto e perceberemos que a imagem está desfocada. O mesmo raciocínio aplica-se quando o objeto da foto se aproxima da lente.

O tamanho do círculo de confusão depende da vários fatores. Uma pessoa com visão normal sente-se confortável em ler e ver imagens a uma distância mínima de 25 cm. A essa distância o círculo de confusão é de cerca de 0,2 mm. Considera-se então que uma ampliação até o formato A4 será vista a essa distância e o círculo de confusão de 0,2 mm será aceitável. Em função do nosso ângulo de visão, imagens maiores terão que ser afastadas para serem enxergadas em sua totalidade. Nesse caso, mesmo em imagens maiores, o círculo de confusão de 0,2 mm é aceitável. Mas, se a imagem ampliada for planejada para ser vista bem de perto, o círculo de confusão deverá ser menor. Quando nos referimos a 0,2 mm como sendo o tamanho do círculo de confusão, estamos falando do tamanho do círculo na imagem já ampliada. Evidentemente, no sensor ou filme, o tamanho do círculo de confusão será 0,2 mm dividido pelo fator de ampliação.

Uma lente não é perfeita e a luz não converge para um ponto infinitesalmente pequeno, mas formará um pequeno “borrão”. Este “borrão” é chamado de círculo de confusão mínimo.

Veremos um pouco mais a frente, quando discutirmos profundidade de campo, como o conceito de círculo de confusão pode nos ajudar a tirar fotos melhores, seja por conseguirmos que tudo esteja em foco seja desfocando o segundo plano de forma a destacar o que está em primeiro plano.

As câmeras, ditas analógicas, usavam filmes químicos que foram padronizados em tamanho. O formato 35 mm era (é) aceito universalmente. Com o advento das câmeras digitais, sensores tentaram emular esse formato, provavelmente para possibilitar uma transição de tecnologias com menores traumas para as pessoas habituadas com o formato 35 mm.

O sensor de uma câmera é retangular, mas a imagem projetada por uma lente é circular. Há, portanto um “desperdício”. Quando se diminui o tamanho do sensor, diminui-se o tamanho da lente e a quantidade de material usada para fabricá-la. Com essa observação nasceram os sensores “cropped”.

O sensor de uma câmera é retangular, mas a imagem projetada por uma lente é circular. Há, portanto um “desperdício”. Quando se diminui o tamanho do sensor, diminui-se o tamanho da lente e a quantidade de material usada para fabricá-la. Com essa observação nasceram os sensores “cropped”.

Vimos que distância focal é a distância entre o centro da lente e o ponto onde os raios de luz que atingem a lente perpendicularmente se concentram após a mesma. É importante saber qual a distância focal da lente sendo utilizada. Nossa visão possui uma distância focal entre 40 e 58 mm. Considera-se normalmente como sendo 50 mm por padrão. Uma lente com distância focal menor do que 50 mm é considerada grande angular e os objetos parecerão na fotografia menores do que apareceriam para o olho humano. Já lentes com distância focal maiores do que 50 mm são consideradas teleobjetivas, aproximando objetos distantes. Esta medida é normalmente usada em câmeras de filme 35 mm ou o seu equivalente digital conhecida com full frame. Quando utilizamos uma câmera digital cropped, o sensor é menor e a medida de distância focal é diferente. Muitas vezes, em uma câmera com sensor cropped, falamos na distância focal equivalente ao de uma câmera 35 mm. Cuidado, quando falamos de câmeras 35 mm não estamos geralmente nos referindo à distância focal da objetiva da câmera, mas ao tamanho do quadro do filme químico utilizado em câmeras antigas. Câmeras digitais full frame possuem um sensor do mesmo tamanho dos quadros de um filme de fotografia antigo (36 x 24 mm). Câmeras digitais cropped possuem um sensor menor. Uma câmera digital com um sensor APS-C de 22 x 15 mm usará uma lente de 31 mm de distância focal para ter o mesmo resultado, do ponto de vista de aproximação ou afastamento, que uma lente de 50 mm em uma câmera com sensor full frame. Complicado? Não é, vamos explorar um pouco isso.

Suponha que você esteja usando uma câmera 35 mm com um determinado tamanho de sensor e possua três lentes. Uma de 50mm, uma grande angular (distância focal menor que 50mm) e outra teleobjetiva (distância focal maior que 50mm).

Com a lente 50mm, a imagem aparecerá no mesmo tamanho aparente que nossa visão nos mostra.

Com a lente 50mm, a imagem aparecerá no mesmo tamanho aparente que nossa visão nos mostra.

Com a lente grande angular, os objetos aparecerão menores. Como o sensor usado é o mesmo utilizado anteriormente, apenas estando mais próximo da lente, caberão mais objetos. Se estivermos fotografando uma paisagem, veremos uma parcela maior da paisagem. Em outras palavras, o ângulo de visão é maior. Grandes angulares são úteis em fotografias de arquitetura e paisagens.

Com a lente grande angular, os objetos aparecerão menores. Como o sensor usado é o mesmo utilizado anteriormente, apenas estando mais próximo da lente, caberão mais objetos. Se estivermos fotografando uma paisagem, veremos uma parcela maior da paisagem. Em outras palavras, o ângulo de visão é maior. Grandes angulares são úteis em fotografias de arquitetura e paisagens.

Com uma teleobjetiva, o sensor estará mais distante da lente, os objetos parecerão maiores e, portanto, como o tamanho do sensor é o mesmo, menos “objetos” caberão na fotografia. É como se estivéssemos aproximando algo distante.

Com uma teleobjetiva, o sensor estará mais distante da lente, os objetos parecerão maiores e, portanto, como o tamanho do sensor é o mesmo, menos “objetos” caberão na fotografia. É como se estivéssemos aproximando algo distante.

Por que, quando usamos um sensor cropped, a distância focal muda para a classificação das lentes como normais, grande angulares ou teleobjetivas?

Por que, quando usamos um sensor cropped, a distância focal muda para a classificação das lentes como normais, grande angulares ou teleobjetivas?

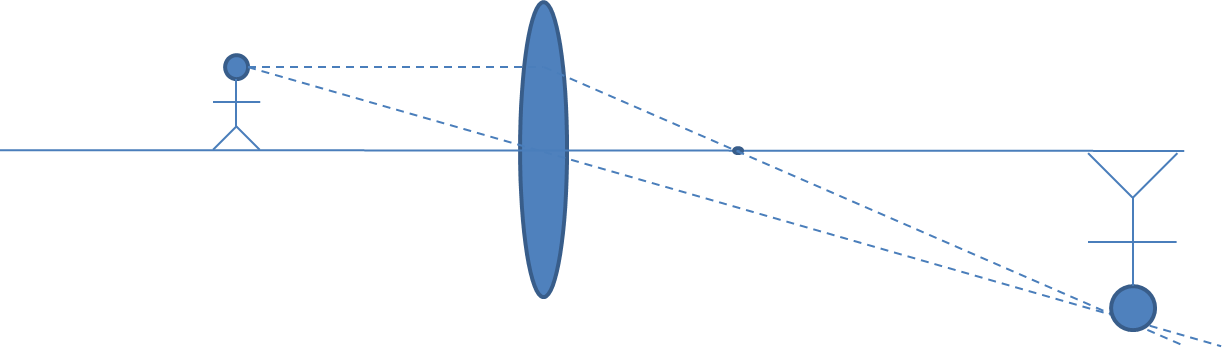

Suponha que a imagem projetada por uma lente 50mm em um sensor full frame (36mm x 24mm) seja a mostrada na figura. Observe a parte da paisagem que será capturada pelo sensor.

Agora se nossa câmera tiver um sensor cropped APS-C de 22 x 15 mm teremos uma porção menor da imagem capturada pelo sensor. Seria como se tivéssemos dado um zoom na imagem. Em outras palavras, uma lente, com distância focal de 50mm, em uma câmera com sensor cropped, será uma teleobjetiva.

Agora se nossa câmera tiver um sensor cropped APS-C de 22 x 15 mm teremos uma porção menor da imagem capturada pelo sensor. Seria como se tivéssemos dado um zoom na imagem. Em outras palavras, uma lente, com distância focal de 50mm, em uma câmera com sensor cropped, será uma teleobjetiva.

Observe o resultado das duas fotos:

Veja como as árvores flamboyant parecem mais próximas (zoom) na foto, à direita, tirada com a câmera com sensor cropped.

O crop factor de um sensor é calculado pela divisão da diagonal de um sensor 35 mm pela diagonal do sensor cropped. A câmera Sony A6500 possui um sensor com 23.5 x 15.6 mm o que corresponde a uma diagonal de 28.21 mm. Um sensor full possui 36 mm por 24 mm e uma diagonal de 43,26 mm. O crop factor dessa câmera é de 43,26/28,21 = 1,53. Para que serve este crop factor? Serve para você determinar equivalência de lentes. Se você quiser uma lente em uma câmera Sony A6500, que dê o mesmo ângulo de visão de uma lente 50 mm em uma câmera full frame, você deverá utilizar uma lente com distância focal 50 mm/1,53 o que resulta em uma distância focal cerca de 30 mm. A câmera Sony A6500 vem, tradicionalmente, com uma lente multifocal 16-50, ou seja, consegue-se alterar a distância focal de 16 até 50mm. Como o crop fator dessa câmera é 1,53, essa lente permite que se varie a distância focal equivalente à de uma câmera full frame de aproximadamente 25 (16 x 1,53) até aproximadamente 77 (50 x 1,53) (de grande angular modesta a teleobjetiva modesta).

Os sensores cropped recebem menos luz e tem desempenho pior em situações de pouca luminosidade. Celulares que possuem sensores bem pequenos sofrem bastante com isso e tentam compensar com o poder computacional dos processadores do celular.

Em uma câmera com sensor full frame, se você deseja tirar fotos com zoom, deverá usar lentes com distância focal maior do que 50 mm. Se deseja tirar fotos de paisagens, com um grande ângulo de visão, deverá usar lentes com distância focal menor do que 50 mm. Lentes de 16 a 35 mm de distância focal são boas para fotos de paisagens. Em câmeras com sensor cropped estes valores devem ser divididos pelo crop factor.

É importante notar que a equivalência vale apenas para o ângulo de visão. Características como profundidade de campo serão diferentes entre lentes para sensores full e cropped com um mesmo ângulo de visão.

Exposição

Vimos que uma lente possui um diafragma que aumenta ou diminui a quantidade de luz que chegará ao sensor da câmera. A câmera também possui um obturador que permanece aberto por um determinado intervalo de tempo. Estes dois dispositivos em conjunto determinam a quantidade de luz que atingirá o sensor. O desafio é propiciar uma exposição boa em toda a imagem. Como muitas cenas que fotografamos podem possuir áreas muito iluminadas e áreas escuras, há o risco de superexposição, quando áreas claras ficarão totalmente brancas ou de áreas de sombras que ficarão totalmente escuras sem que se consigamos ver detalhes. Chama-se isto de “clipping”. Deve-se evitar o clipping sempre que possível, pois os detalhes perdidos em áreas claras ou escuras não poderão ser recuperados posteriormente por melhor que seja o software de edição de fotos usado. Para evitar o clipping, ou minimizá-lo, é, em geral, melhor tirar uma foto ligeiramente superexposta do que subexposta. Em um software de edição de fotos é possível corrigir a superexposição ou subexposição, mas no caso de subexposição, a correção poderá introduzir “ruídos” na imagem, pois os sensores, nessas áreas receberam uma quantidade muito pequena de luz e pequenas variações podem significar muito. Esquecendo qualquer rigor técnico, seria como se um sensor recebesse luminosidade em uma escala de 0 a 100. Uma diferença de uma unidade em um valor 1 unidade de luminosidade é 100% de variação, já uma unidade em 100 de luminosidade é apenas 1%. Em outras palavras a reprodução das condições de cor e luminosidade em um sensor são mais fiéis quando a luminosidade é maior.

Quando nos referimos a uma determinada abertura do diafragma nos referimos ao “f stop” utilizado. Em português utilizamos o termo “parada”. Esta medida é indicada como f/1.2, f/2.8, f/4, f/5.6, f/8, f/11, f/16, f/22 e assim por diante. Note que é uma fração onde o “f” refere-se à distância focal da lente sendo utilizada. Assim, uma abertura f/2.8 é muito maior do que uma abertura f/22. Meio estranho? Nem tanto. Se tomarmos uma lente 50 mm de distância focal, uma abertura f/2.8 terá 50/2.8=17.9 mm de diâmetro. Já uma abertura f/22 terá um diâmetro de 50/22=2.27 mm de diâmetro. Isto faz com que a quantidade de luz que passa em uma determinada abertura seja a mesma não importando a distância focal da lente sendo utilizada. E por que estes números “quebrados” como 1.2, 2.8, 4, 5.6, 8 etc.? Porque, se calcularmos as áreas de cada abertura veremos que cada uma dela é metade da anterior. Uma abertura f/2.8 permitirá a entrada do dobro da quantidade de luz que a de f/4 que por sua vez permitirá o dobro da quantidade de luz de uma f/5.6 e assim por diante.

É importante memorizarmos que uma abertura 2.8 é MAIOR que uma 11, ou seja usa-se uma abertura 2.8 quando temos cena mais escura do que quando fotografamos com abertura 11.

Controla-se também a quantidade de luz que chegará ao sensor através do obturador. Ele permanecerá aberto por mais ou menos tempo permitindo que mais ou menos luz passe por ele. O tempo que normalmente o obturador fica aberto pode ir de milissegundos até vários segundos. Em casos específicos pode ficar aberto por vários minutos. O que é determinante é a quantidade de luz que atingirá o sensor. Uma abertura do diafragma pequena obrigará um tempo de abertura do obturador maior do que seria necessário se a abertura do diafragma fosse maior. Tempos de abertura grandes podem desfocar totalmente uma imagem se a câmera não estiver em um tripé ou em algum local onde a câmera esteja totalmente imóvel. Uma mão não firme fará a câmera se deslocar “borrando” a imagem. O mesmo ocorrerá se os objetos ou pessoas sendo fotografados se moverem enquanto o obturador estiver aberto. Neste caso, apenas o que se mover estará “borrado”. Algumas vezes isto é desejável do ponto de vista artístico.

Em uma determinada situação de iluminação vamos supor que a abertura seja f/4 e a o tempo de abertura do obturador seja 1/200 segundos. Poderíamos obter o mesmo resultado com uma abertura menor, de f/5.6 e um tempo de abertura de 1/100 segundos. Lembre-se que uma abertura f/5.6 por ter uma área a metade de uma abertura f/4 permitirá entrar a metade da luz então precisaremos do dobro do tempo para que a mesma quantidade de luz atinja o sensor (1/100 segundos). Conclui-se assim que o fotógrafo pode escolher uma pequena abertura e um tempo de abertura grande ou uma grande abertura e um tempo de abertura pequeno ou qualquer combinação que permita que a mesma quantidade de luz atinja o sensor. Como tomar essa decisão? Aqui entra toda a teoria que vimos até o momento.

Antes de avançarmos é importante que fique claro que, muitas vezes, ao referirmos ao tempo de abertura do diafragma, falamos em velocidade do obturador. Na realidade as câmeras mostram tempos de abertura, não velocidade. Assim, um tempo de abertura de 1/1000 é menor do que um tempo de 1/100, mas representa uma velocidade maior do obturador, pois ele abre e fecha 10 vezes mais rápido. Preste atenção ao ler um texto se está-se falando de velocidade ou tempo de abertura do diafragma. Um tempo maior (1/100, por exemplo) permite que entre uma maior quantidade de luz pelo diafragma do que um tempo menor (1/1000, por exemplo). É equivalente dizer que uma velocidade menor (1/100, por exemplo) permite que entre uma maior quantidade de luz pelo diafragma do que uma velocidade maior (1/1000, por exemplo).

Profundidade de campo

Vimos que uma lente a uma certa distância do sensor, só mostrará em foco perfeito elementos que estiverem exatamente a uma determinada distância da câmera. Se esse elemento se afastar continuamente da câmera, um círculo crescente se projetará no sensor, não mais um ponto. Por limitação de nossa visão, demorará um tempo até percebermos que se trata de um círculo, não mais um ponto e teremos um foco aceitável. O mesmo ocorrerá se o elemento se aproximar da câmera. Essa distância entre o ponto mais distante ou mais próximo da câmera, onde se consegue um foco aceitável, é chamada de profundidade de campo.

Se tivermos uma grande abertura, teremos um cone com um ângulo grande e o tamanho do círculo de confusão será logo atingido, portanto teremos uma profundidade de campo pequena. Já com uma pequena abertura o ângulo do cone formado será pequeno e o círculo de confusão demora a ser atingido. Conclusão: aberturas pequenas propiciam uma maior profundidade de campo enquanto aberturas grandes uma pequena profundidade de campo. Da mesma forma, para uma mesma abertura, se estabelecermos o foco em nossa câmera em um elemento distante da câmera, a profundidade de campo será maior do que se ele estivesse mais perto da câmera.

Se você vai tirar fotografia de uma paisagem, com, por exemplo, flores em um primeiro plano, casas um pouco mais para frente, um grupo de árvores mais adiante e montanhas ao fundo, é bem possível que você queira que tudo esteja em foco. Neste caso devemos usar uma abertura pequena do diafragma, pois a profundidade de campo será maior nessas condições. O tempo de abertura do obturador será determinado em função dessa abertura do diafragma. Já se quisermos tirar uma fotografia de uma pessoa em primeiro plano, podemos obter um resultado muito bonito se tivermos o segundo plano desfocado. Toda a atenção ficará no primeiro plano. Para isso usamos uma grande abertura que possibilita uma pequena profundidade de campo. O tempo do obturador é determinado em função dessa abertura.

Bem, seria tudo muito bom se não houvesse um pequeno problema. A difração (não confunda com refração que vimos há pouco). A luz se comporta como uma onda e quando encontra um obstáculo, se curva. Não vamos entrar nos detalhes físicos, mas basta lembrar que quando a luz passa rente à borda de um obstáculo sólido, ela desvia-se de seu curso. Em grandes aberturas do diafragma isto não é um problema porque a quantidade de raios de luz (me perdoem os físicos pela simplificação) que “raspam” as bordas da abertura do diafragma é muito pequena em comparação com os que passam longe da borda. Quando a abertura do diafragma é, no entanto, pequena, essa quantidade é significativa. Isto acaba representando uma perda no foco. Como parte dos raios provenientes de um ponto do elemento sendo fotografado são desviados, eles acabam não se concentrando em um ponto, mas em torno do ponto. A imagem ficará menos nítida. Moral da história. Vimos que quando queremos ter foco na maioria dos elementos de uma foto, como por exemplo, de uma paisagem, deveríamos usar uma abertura pequena. No entanto, se utilizarmos a menor abertura possível, teremos o efeito da difração. Cada lente possui um “sweet spot” que é a abertura em que ela funciona melhor e a difração tem influência desprezível na qualidade da imagem. Normalmente f/11 é uma abertura boa de ser usada. Já, com f/22, os efeitos da difração serão notados. Mas, investigue qual o sweet spot da lente que você usa, pois ele é uma característica que varia de lente para lente.

ISO

Uma outra forma de ajustar a exposição é alterando a sensibilidade do sensor. Em filmes químicos, sobre uma película de celulose transparente era depositado uma gelatina com minúsculas partículas sensíveis a luz. Como essas partículas são minúsculas, é necessário que a luz que as atingem seja suficientemente forte para que a reação química aconteça. Uma forma de contornar esse problema e permitir que fotos fossem tiradas em situações de fraca luminosidade foi aumentar o tamanho das partículas sensíveis. Desse modo, a quantidade de luz que atinge uma partícula acaba sendo maior porque, apesar de ser pouco intensa, a área que recebe a luz é maior. Um efeito colateral disso é que o tamanho maior dos “grãos” acaba prejudicando a qualidade da foto, pois os “grãos” serão visíveis principalmente em grandes ampliações. É utilizado um número para identificar a sensibilidade do filme. Por exemplo, ISO 100 caracterizava filme para ser usado em ambiente externos em dias ensolarados. Já ISO 400 usado em fotos feitas dentro de casa, por exemplo.

Nas câmeras digitais também existe o conceito ISO. O sensor é constituído por milhões de elementos sensíveis à luz. A luz recebida por cada sensor é amplificada para poder ser processada. Quando se escolhe ISO maior, a amplificação é maior. Infelizmente, mesmo em sensores de alta qualidade, a amplificação de cada sensor individual não é igual e aparecerá “ruído” na foto. Quanto maior o ISO, maior o ruído. Muitas vezes é melhor ter uma foto com ruído do que não a ter. Tenha em mente que é sempre interessante tirar fotos com o menor ISO possível. Valores típicos de ISSO são 100, 200, 400, 800... Note que a cada vez que dobra o valor do ISO, dobra a sensibilidade. Como exemplo, se trabalharmos com uma velocidade do obturador constante, podemos obter a mesma luminosidade com uma abertura f/5.6 e ISO 100 ou abertura f/8 e ISO 200. Dobrar o valor ISO corresponde a reduzir pela metade a abertura. Lembre-se que f/5.6 é uma abertura que permite que o dobro da quantidade de luz passe em relação a abertura f/8. O mesmo raciocínio valeria se fixássemos a abertura e variássemos a velocidade do obturador. Se fixássemos uma abertura f/4.5 para ISO 100 teríamos uma velocidade de obturador de 1/320. Já para ISO 200, teríamos uma velocidade de obturador de 1/640. Em outras palavras, como ISO 200 é 2 vezes mais sensível que ISO 100, para ISO 200 necessitamos metade do tempo de abertura do diafragma.

Vimos então que para determinar a exposição correta temos três variáveis: a abertura do diafragma, o tempo de abertura do obturador e o ISO.

Para escolher o valor de cada uma das três variáveis deve-se levar em conta que:

- Quanto maior a abertura, menor a profundidade de campo. Quanto menor, maior a profundidade de campo.

- Quanto maior a velocidade menos possibilidade de elementos borrados por movimento na foto.

- Quanto maior o ISO, maior a possibilidade de ruído na foto.

As câmeras possibilitam várias formas de determinar a exposição correta:

Automática: a câmera determinará a abertura e o tempo do obturador não permitindo ao fotógrafo determinar o que deseja como resultado. A inteligência embutida nas câmeras fará com que ela distinga se está-se tirando foto de uma paisagem ou de uma pessoa, ajudando a ter um resultado bom. Para colocar a câmera no modo automático, normalmente o botão de modo possui a opção AUTO. E como se você estivesse tirando fotos com um celular no modo normal. Alguns celulares possuem um modo profissional que permite trabalhar com os modos descritos a seguir.

Automática: a câmera determinará a abertura e o tempo do obturador não permitindo ao fotógrafo determinar o que deseja como resultado. A inteligência embutida nas câmeras fará com que ela distinga se está-se tirando foto de uma paisagem ou de uma pessoa, ajudando a ter um resultado bom. Para colocar a câmera no modo automático, normalmente o botão de modo possui a opção AUTO. E como se você estivesse tirando fotos com um celular no modo normal. Alguns celulares possuem um modo profissional que permite trabalhar com os modos descritos a seguir.

Manual: o fotógrafo deve determinar a abertura e a velocidade do obturador. Usado normalmente em situações específicas como em fotos astronômicas.

Manual: o fotógrafo deve determinar a abertura e a velocidade do obturador. Usado normalmente em situações específicas como em fotos astronômicas.

Prioridade de abertura: Método preferido por muitos fotógrafos. Você determina a abertura em função do que deseja: grande profundidade de campo no caso de uma paisagem ou pequena profundidade de campo no caso de um retrato. A câmera determinará a velocidade do obturador. Pode ocorrer de, para a abertura escolhida, a velocidade do obturador ser muito lenta, o que sujeitaria a foto a ficar tremida ou com rastros de objetos em movimento. A solução é aumentar o ISO usado. Muitas máquinas podem fazer isso automaticamente. Basta você indicar qual a menor velocidade do obturador aceitável. Se a câmera determinar que precisa de uma velocidade menor ainda (maior tempo de abertura), a câmera aumentará o ISO em vez de diminuir a velocidade mais ainda. No seletor de modo da maioria das câmeras escolhe-se a opção A (Aperture). Em algumas câmeras, como as da marca Canon, escolhe-se a opção Av (Aperture value).

Prioridade de abertura: Método preferido por muitos fotógrafos. Você determina a abertura em função do que deseja: grande profundidade de campo no caso de uma paisagem ou pequena profundidade de campo no caso de um retrato. A câmera determinará a velocidade do obturador. Pode ocorrer de, para a abertura escolhida, a velocidade do obturador ser muito lenta, o que sujeitaria a foto a ficar tremida ou com rastros de objetos em movimento. A solução é aumentar o ISO usado. Muitas máquinas podem fazer isso automaticamente. Basta você indicar qual a menor velocidade do obturador aceitável. Se a câmera determinar que precisa de uma velocidade menor ainda (maior tempo de abertura), a câmera aumentará o ISO em vez de diminuir a velocidade mais ainda. No seletor de modo da maioria das câmeras escolhe-se a opção A (Aperture). Em algumas câmeras, como as da marca Canon, escolhe-se a opção Av (Aperture value).

Prioridade de velocidade do obturador: Neste caso você determina a velocidade. Este método é interessante quando se está tirando fotografias de objetos em movimento. Dependendo do que você deseja, você pode querer que elementos em movimento, por exemplo, uma criança ou um esportista, apareçam bem focados. Neste caso você usará um tempo de exposição bem curto. Já, em algumas situações, você deseja que se forme um rastro atrás do elemento em movimento. Neste caso usará uma velocidade lenta. Lembre-se, no entanto, que talvez seja necessário usar um tripé para que a foto toda não fique tremida. Como você está tirando foto com tempo de exposição muito curto pode ser que as condições de iluminação não permitam uma correta exposição mesmo com a maior abertura possível. Também pode ser que você queria usar uma abertura não muito grande por conta da profundidade de campo. Neste caso a solução é aumentar o ISO utilizado. Na maioria das câmeras, escolhe-se a opção S (Shutter speed). Em algumas câmeras, a opção usada é a Tv (Time value).

Prioridade de velocidade do obturador: Neste caso você determina a velocidade. Este método é interessante quando se está tirando fotografias de objetos em movimento. Dependendo do que você deseja, você pode querer que elementos em movimento, por exemplo, uma criança ou um esportista, apareçam bem focados. Neste caso você usará um tempo de exposição bem curto. Já, em algumas situações, você deseja que se forme um rastro atrás do elemento em movimento. Neste caso usará uma velocidade lenta. Lembre-se, no entanto, que talvez seja necessário usar um tripé para que a foto toda não fique tremida. Como você está tirando foto com tempo de exposição muito curto pode ser que as condições de iluminação não permitam uma correta exposição mesmo com a maior abertura possível. Também pode ser que você queria usar uma abertura não muito grande por conta da profundidade de campo. Neste caso a solução é aumentar o ISO utilizado. Na maioria das câmeras, escolhe-se a opção S (Shutter speed). Em algumas câmeras, a opção usada é a Tv (Time value).

Modo programado: Você pode alterar a velocidade ou a abertura. É uma combinação dos dois métodos anteriores.

Modo programado: Você pode alterar a velocidade ou a abertura. É uma combinação dos dois métodos anteriores.

HDR

Quando determinamos a exposição de uma fotografia há de se levar em conta, como vimos, que diferentes partes da foto podem necessitar exposições diferentes o que não é possível de se conseguir em uma câmera. As câmeras podem determinar a iluminação de uma cena de várias formas. Podem pegar e medir a luz em um único ponto ou região. Este ponto pode ser o centro da foto ou um ponto escolhido pelo fotógrafo. As demais partes da foto podem não ficar corretamente expostas, mas a parte importante da foto ficará. Podem também pegar uma média da luminosidade da cena toda. Isto só funcionará bem em cenas com pouca diferença de luminosidade em sua totalidade. Outra forma é a média ponderada. É calculada a média da luminosidade, mas com um peso maior na parte central da foto.

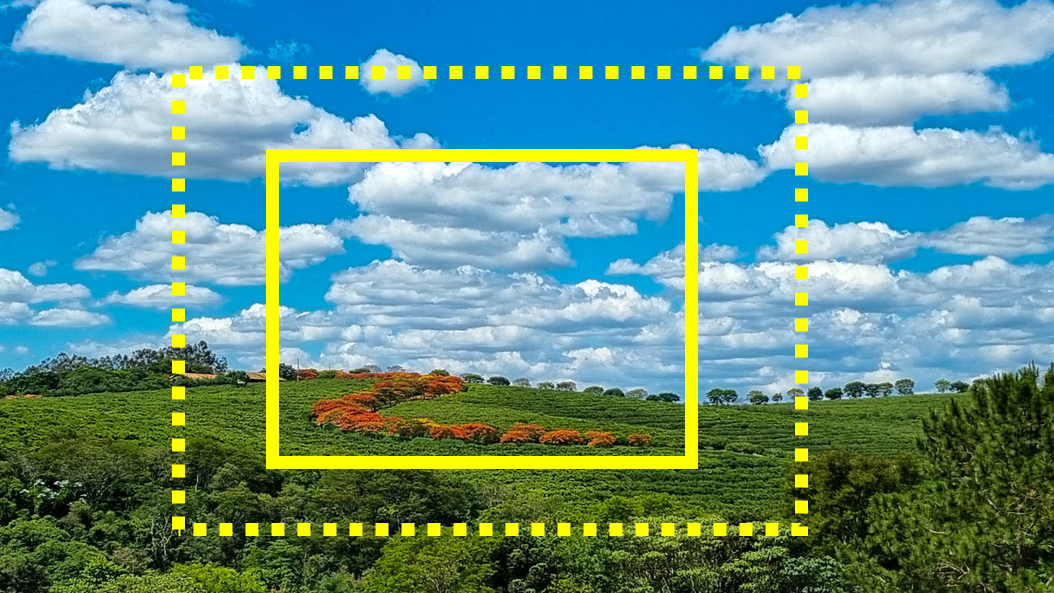

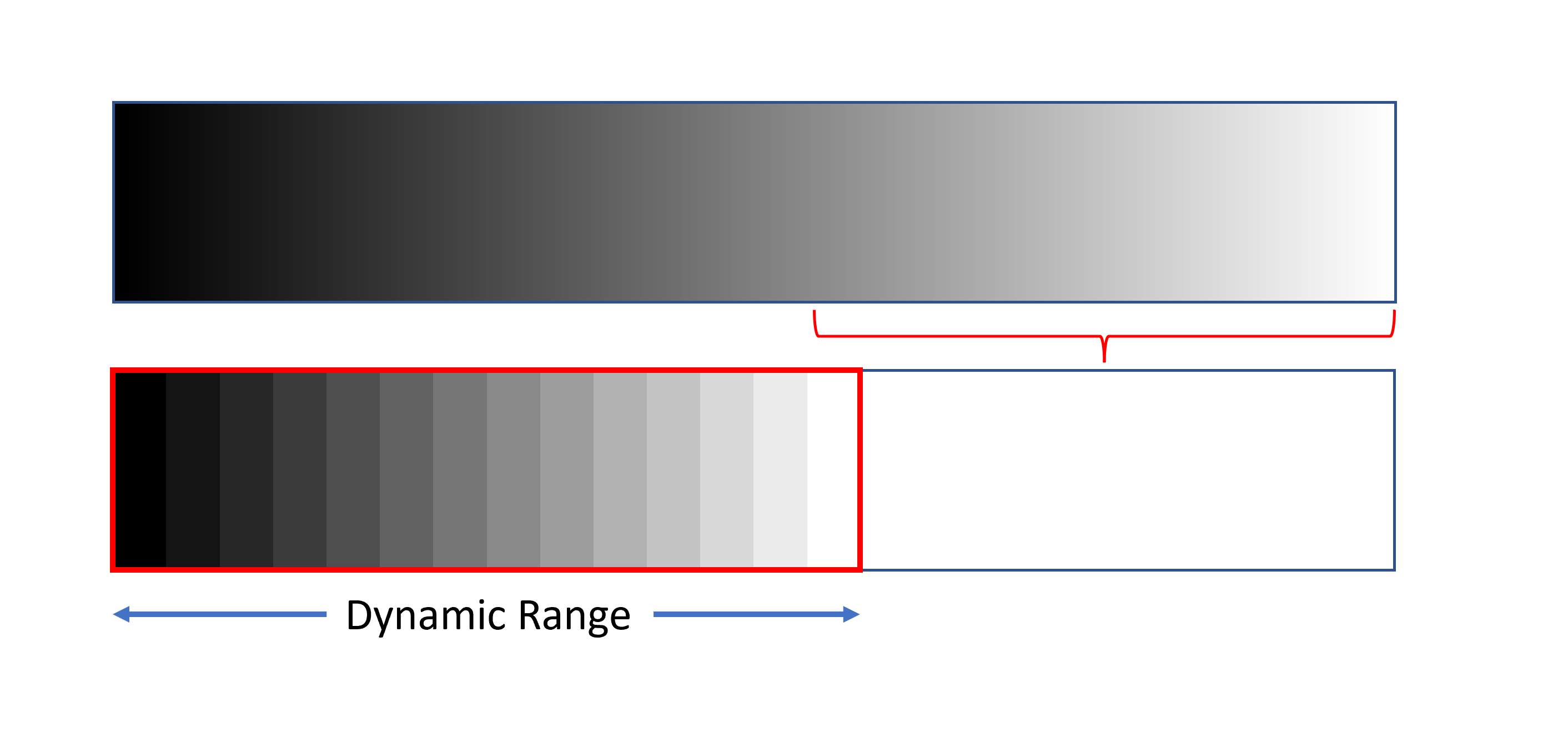

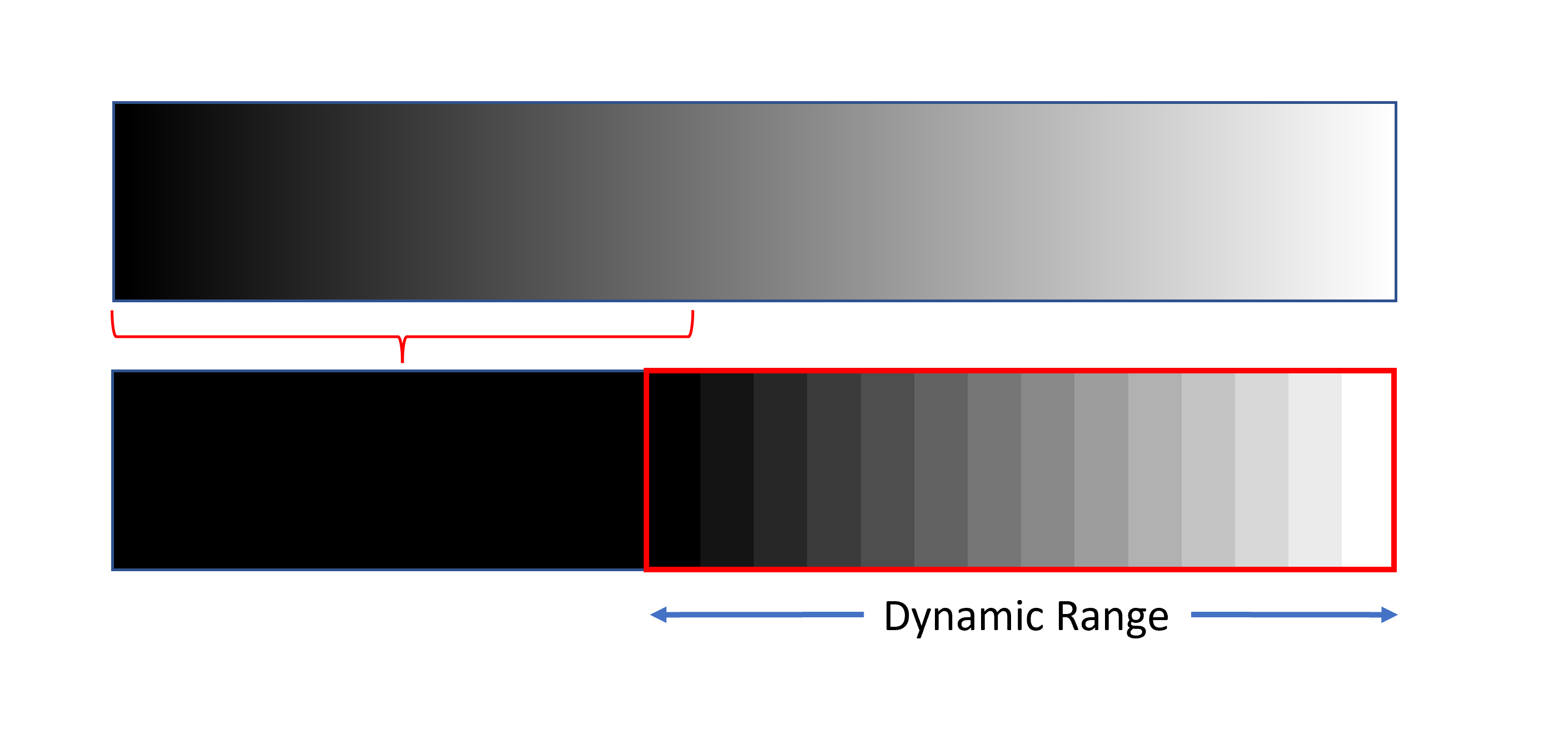

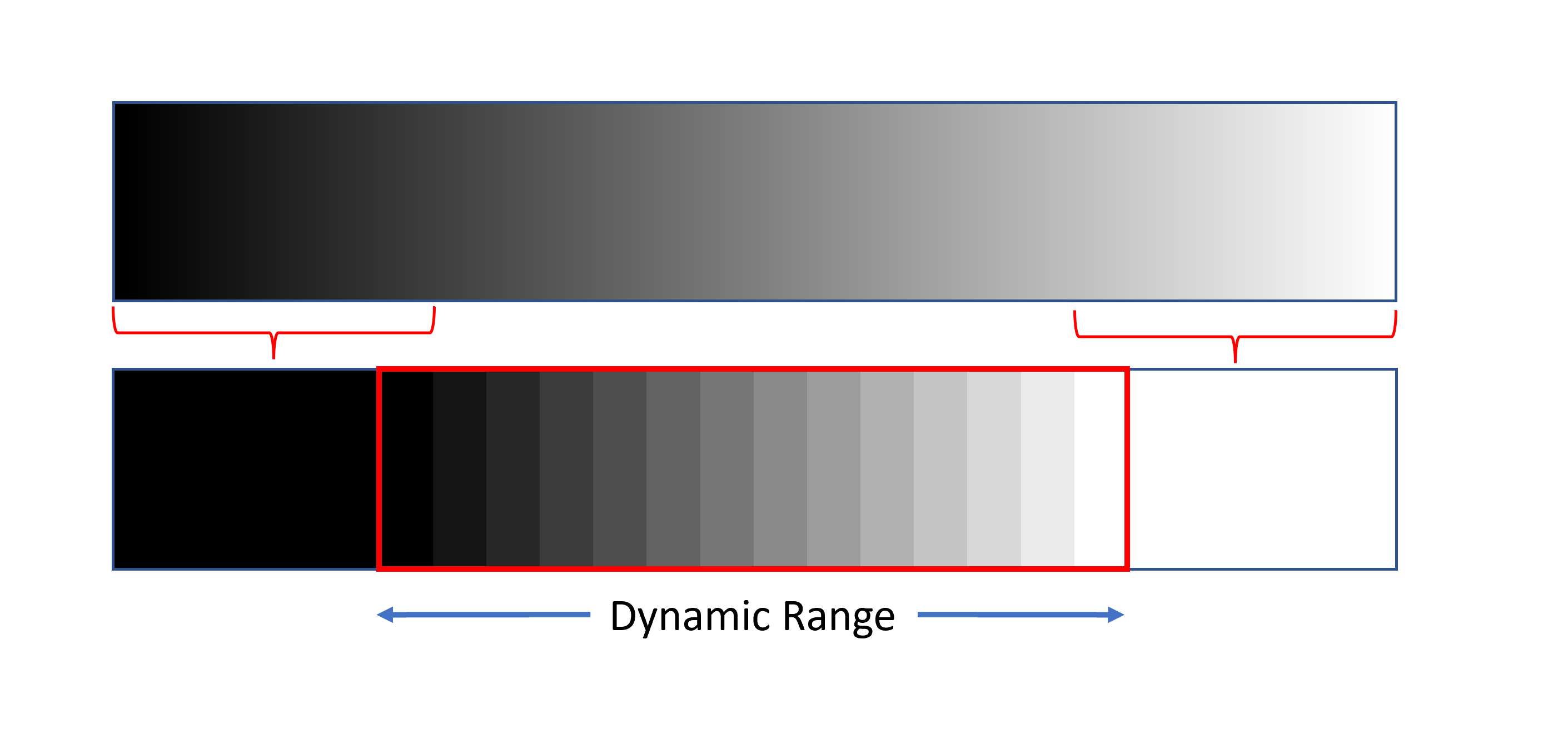

Seja qual for a forma escolhida, outro ponto a ser considerado é que o alcance dinâmico de nossa vista é maior do que o de câmeras fotográficas. Ou seja, as câmeras conseguem distinguir tonalidades apenas em uma faixa restrita do espectro de luminosidade. Imagine uma graduação de luminosidade partindo do puramente preto até o puramente branco passando por toda a escala intermediária de cinza. Se quisermos detalhes dos itens mais escuros, não conseguiremos detalhes das áreas mais claras que serão vistas todas como branco puro. Já, se quisermos ver os detalhes das partes claras, perderemos os detalhes das partes mais escuras da cena. Uma cena na praia em um dia bem ensolarado, pode ter, por exemplo, pessoas na sombra de árvores e areia, nuvens e mar muito bem iluminados. Nessa situação, se você estabelecer a exposição para mostrar a parte da cena na sombra com detalhes, a praia, mar e nuvens aparecerão muito brancos. Se você, ao contrário, estabelecer a exposição de forma que o mar, a praia e as nuvens apareçam com detalhes, a cena na sombra aparecerá muito escura sem que se consiga ver os detalhes.

Vemos um exemplo nestas duas fotos. A foto da direita tem o céu azul, a vegetação está com uma cor natural e os edifícios também. Em compensação as pessoas na rua e a própria rua estão muito escuras. Já na foto da direita, o céu e a edificação estão muito claros, enquanto as pessoas e a rua estão com uma luminosidade aceitável.

A foto abaixo, embora esteja longe de ser uma boa foto, possui uma qualidade. Não há clipping, ou seja, não há áreas super ou sub expostas. Uma pessoa com experiência em softwares de edição de fotos pode efetuar correções tornando a foto em uma foto de boa qualidade, desde que não exista clipping de claros ou sombras.

Dynamic range ou, em português, gama dinâmica, faixa dinâmica ou alcance dinâmico refere-se a faixa de luminosidade do mais escuro ao mais claro que nosso olho ou o sensor de uma câmera fotográfica consegue distinguir. Objetos com luminosidades fora dessa faixa são vistos como brancos ou pretos dependendo do extremo da faixa sendo ultrapassado.

A faixa dinâmica é medida em stops (paradas). A faixa dinâmica do olho humano corresponde a 20 a 24 paradas. Lembrando que de um stop ao anterior a quantidade de luz dobra, se temos 20 stops teremos uma diferença de luminosidade 1.000.000 de vezes maior entre os extremos (220). Câmeras digitais possuem uma faixa dinâmica entre 12 e 14 stops apenas. Algumas câmeras chegam a 15 que corresponde apenas a uma diferença de luminosidade de 32.768 vezes (215). Uma câmera analógica antiga tem uma faixa dinâmica de 13. Este é outro fator a ser considerado quando se compra uma câmera.

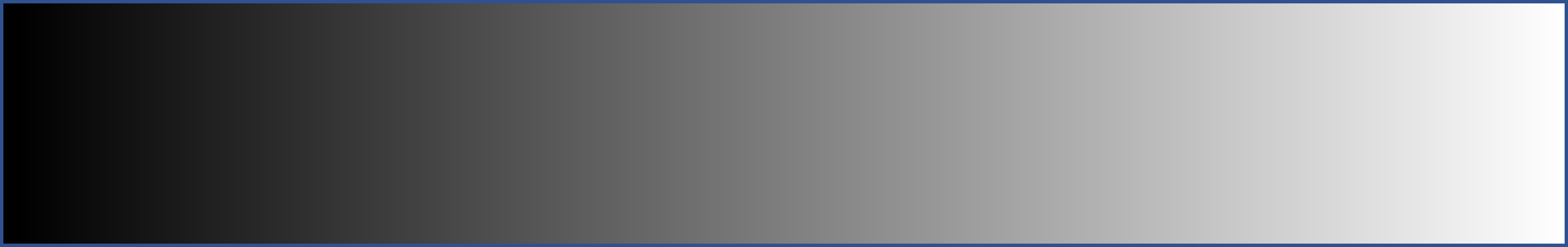

Para entender melhor, vamos imaginar uma escala de cinza. Nossa visão é analógica, ou seja, as tonalidades mudam de modo contínuo.

Supondo que esta seja a gama de luminosidade de uma cena que vai do puro branco ao preto total, teremos limitações com uma câmera. Se escolhermos mostrar as sombras com todos os seus detalhes, perderemos os tons claros (highlights) que aparecerão como brancos.  Ocorrerá o chamado clipping dos claros (highlights), ou em palavras mais simples, o detalhe das tonalidades claras da imagem é perdido e irrecuperável. Na figura ao lado, o segundo retângulo mostra como a câmera “vê” a cena.

Ocorrerá o chamado clipping dos claros (highlights), ou em palavras mais simples, o detalhe das tonalidades claras da imagem é perdido e irrecuperável. Na figura ao lado, o segundo retângulo mostra como a câmera “vê” a cena.

Já, se escolhermos mostrar os tons claros com todos os seus detalhes, perderemos os detalhes dos tons mais escuros que serão mostrados como pretos. Neste caso perderemos os detalhes das sombras que sofrerão clipping.

Já, se escolhermos mostrar os tons claros com todos os seus detalhes, perderemos os detalhes dos tons mais escuros que serão mostrados como pretos. Neste caso perderemos os detalhes das sombras que sofrerão clipping.

Uma solução intermediária é possível, mas embora em menor grau, perderemos tons mais claros e mais escuros da imagem. Neste caso, apenas os tons intermediários ficarão corretamente expostos. Teremos perdas de detalhe tanto nas sombras quanto nos tons claros.

perderemos tons mais claros e mais escuros da imagem. Neste caso, apenas os tons intermediários ficarão corretamente expostos. Teremos perdas de detalhe tanto nas sombras quanto nos tons claros.

É difícil comparar uma câmera fotográfica com o olho humano. A nossa visão estaria mais próxima à uma filmadora. Nas três imagens ilustrando Dynamic Range, mostramos os tons de cinza mudando de modo discreto, não continuamente como quando descrevemos a escala de cinzas vistas por humanos. Isto é explicado pela forma como uma câmera armazena, a luminosidade capturada em um pixel do sensor. Cada elemento fotosensível representado um pixel “enxerga” de modo analógico a luminosidade ou, em outras palavras, a variação de luminosidade é enxergada de modo contínuo. A câmera transforma a luminosidade de um pixel lida pelo sensor em um número inteiro. A luminosidade capturada será 20 ou 21, por exemplo. Se o pixel tiver uma luminosidade 20,4 ela será arrendondada para 20. Se for 20,6 será arredondada para 21. Na câmera a6500 da Sony, cada pixel é representado por 14 bits. Cada bit pode armazenas um valor, zero ou um. Ora, se temos 14 bits poderemos representar 16.384 combinações ou graus de luminosidade. 00000000000000 representa zero luminosidade, ou seja, o preto puro e 11111111111111 representa 16.383 ou o branco absoluto. Uma câmera que armazenasse em 12 bits, conseguiria representar 4.096 intensidades diferentes de luminosidade. A perda de qualidade, porém, não é tão grande. Nossa visão não tem um comportamento linear com a luminosidade como uma câmera. Tem um comportamento logarítimo. Distinguimos muito bem diferenças de luminosidade em tons mais escuros, mas não tão bem em tons mais claros. Se tivermos uma lâmpada iluminando uma sala e acendermos mais uma lâmpada igual à primeira, uma câmera enxergará o dobro da luminosidade o que não ocorrerá com nossa visão que enxergará a segunda cena apenas um pouco mais clara do que a primeira. Assim, uma câmera armazenando luminosidade em um número maior de bits não trará um ganho muito grande nos tons mais claros que não conseguirão ser distinguidos por nossa visão.

Uma outra forma de se resolver a limitação do Dynamic Range das câmeras é usar a técnica conhecida por HDR (High Dynamic Range) disponível na própria câmera (mesmo a de muitos celulares). A câmera tirará mais de uma foto com exposições diferentes. Por exemplo, poderia tirar uma foto com abertura menor permitindo que as partes bem iluminadas da cena apareçam com todos os detalhes enquanto as partes escuras não mostrariam detalhes. Tiraria também uma foto com abertura intermediária e outra com uma abertura maior, o que faria que as partes escuras da cena fossem corretamente expostas enquanto as partes claras seriam superexpostas. O processador combinará as fotos tiradas, construindo uma foto onde tanto as partes escuras quanto as partes claras mostrariam os detalhes corretamente. Um problema dessa técnica é que, como são tiradas várias fotos, você pode mover a câmera ou os elementos da cena podem se mexer. Algumas câmeras conseguem corrigir pequenos deslocamentos da câmera, mas não elementos que se movem.

Esta mesma técnica pode ser utilizada manualmente. A câmera tira várias fotos (você determina a quantidade e a variação da abertura entre cada foto). Posteriormente, em um software de edição de fotos você combina as fotos. Esses softwares fazem ajustes e conseguem eliminar “fantasmas” que surgem quando algo se moveu. O software detecta o que se moveu e pega a melhor imagem desse elemento ignorando outras em posições diferentes.

Balanço de brancos

O tipo de iluminação usada ao tirar a foto também influi no resultado. Nossa visão consegue se adaptar melhor do que uma câmera fotográfica a diferentes tipos de iluminação. Independente da iluminação usada, conseguimos, por exemplo, distinguir objetos brancos. Já uma câmera irá distorcer as cores. As câmeras possibilitam que você indique o tipo de luz utilizada que pode ser luz solar, luz de pôr ou nascer do sol, fluorescente, vapor de sódio, incandescente etc. Os softwares de edição também possibilitam que seja feita a correção, mesmo que a foto tenha sido tirada com a câmera ajustada para a luz incorreta. Se a imagem tiver sido salva em formato RAW, a correção será perfeita. Se em formato JPG a correção será praticamente perfeita. O balanço de brancos também é conhecido como ajuste da temperatura das cores. Algumas vezes, por motivos artísticos, pode-se ajustar o balanço de brancos para uma luz diferente daquela usada para tirar a fotografia.

Formato da imagem salva

As câmeras digitais podem salvar as imagens em formato comprimido JPG ou em formato não comprimido RAW. O formato RAW não é padronizado e cada fabricante estabelece o seu. No formato RAW as informações de cada pixel são armazenadas no arquivo. Isto torna os arquivos muito grandes. Uma máquina com sensor de 24 megapixels gerará fotos com mais de 24 M para cada foto tirada. Já o formato JPG utiliza várias técnicas matemáticas e considera que o ser humano não consegue perceber pequenas variações em determinadas cores. Os arquivos, mesmo sem perder muita qualidade, podem ter 10% do tamanho de um arquivo RAW. A grande vantagem do formato RAW é que TODAS as informações capturadas quando a foto foi tirada são guardadas. Você consegue alterar algumas dessas informações como abertura, balanço de branco etc. como se tivesse feito isso quando a foto foi tirada. Obviamente se a foto foi superexposta ou subexposta e detalhes foram perdidos em partes escuras ou claras da foto, estes não poderão ser recuperados. Você consegue também fazer ajustes de balanço de branco e exposição em fotos no formato JPG, mas eles não serão tão precisos. Um ponto importantíssimo é que cada vez que você faz alterações em um arquivo JPG e salva, a qualidade da foto é deteriorada, pois o algoritmo de compactação é aplicado novamente. O programa de edição de fotos Lightroom® da Adobe™ não altera a foto original, mas guarda em um arquivo separado as alterações que você eventualmente tenha feito. A desvantagem é que as alterações somente serão vistas em aplicativos que consigam ler esses arquivos de alterações da Adobe. Se você quiser publicar a foto com alterações, deverá exportar a foto para um arquivo novo. A vantagem do esquema do Lightroom da Adobe é que você não destruirá seu original se fizer uma má alteração.

Muitas câmeras e celulares permitem salvar as fotos tiradas nos dois formatos. Na maioria das vezes a câmera faz pequenos ajustes na foto em formato JPG, mas não no formato RAW. Isto permite que você publique em uma rede social uma foto que tirou sem ter que esperar por um pós-processamento em um editor de fotos. Se o seu objetivo é apenas publicar as fotos tiradas em redes sociais, salvar em JPG apenas pode ser uma opção boa. Você poderá salvar um número enorme de fotos em um único cartão de memória. Já se salvar em formato RAW, tenha cartões de memória de reserva. O olho humano distingue uma variedade de tons muito maior do que o sensor de uma câmera fotográfica bem como possui um dynamic range muito maior, como já vimos. O formato RAW armazena uma variação de tons maior do que o formato JPG e possibilita um dynamic range maior. Na câmera a6500 da Sony, o formato RAW representa mais de 4 bilhões de cores, já um arquivo JPG representa um pouco menos de 17 milhões de cores. É importante salientar que o formato RAW é o simples armazenamento de todas as informações capturadas pelo sensor. A opção que temos é salvar ou não essas informações. Se optarmos por salvá-las, um arquivo no formato RAW, que, como vimos, é diferente para cada fabricante, será armazenado no cartão de memória da câmera.

Como funciona o sensor da maioria das câmeras

Para tirar boas fotos não é necessário saber como funciona o sensor. Eu, no entanto, acho interessante conhecer, mesmo que não profundamente, como funcionam os aparelhos que uso. Acredito que podemos usar melhor, se soubermos como funcionam.

De modo bem rudimentar, o pixel de um sensor é constituído de um elemento fotossensível, um capacitor para armazenar a carga elétrica gerada e um amplificador de sinal.

Um capacitor é formado por duas placas metálicas montadas como um sanduiche cujo recheio é um material isolante. Se você ligar uma bateria a um capacitor, como as placas metálicas estão muito próximas, as cargas negativas atrairão as cargas positivas e o capacitor ficará carregado de eletricidade. Essa característica do capacitor é utilizada em fontes de energia de equipamentos eletrônicos para estabilizar a tensão. Quando a tensão fornecida cai, o capacitor se descarrega suprindo carga elétrica. Isto pode ser observado quando desligamos muitos aparelhos eletrônicos como um modem de internet ou de TV a cabo. Mesmo desligado da tomada, um led de sinalização ainda permanece acesso por um tempo. A eletricidade que alimenta o led proveem do capacitor sendo descarregado. Quando apertamos o botão do obturador de uma câmera fotográfica o sensor é exposto a imagem projetada pela lente. Os elementos fotossensíveis de cada pixel gerarão uma carga elétrica proporcional a intensidade luminosa recebida. Esta carga elétrica é armazenada em um capacitor. Quando o obturador for fechado temos cada capacitor carregado com a carga representando a luminosidade de cada pixel. Esta carga é medida, amplificada e transformada em um número como já explicado. Quando o pixel recebe muita luz o capacitor atinge o limite de carga que consegue armazenar. Mais luz chegando não será representada pelo aumento de carga armazenada. Isto é o clipping de claros já explicado acima. Quando chega muito pouca luz, praticamente muito pouca carga é armazenada e temos o clipping de sombras. A amplificação do sinal pode introduzir ruído quando a carga é muito pequena. Por este motivo, como já explicamos, é melhor ter fotos um pouco sobre expostas do que sub expostas desde que não exista clipping de claros.

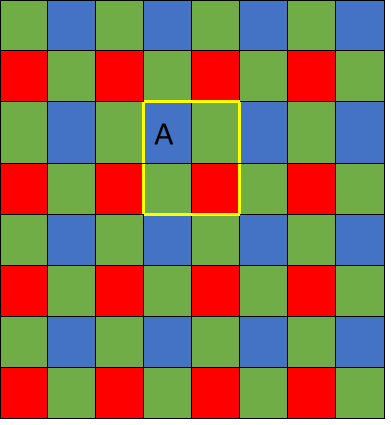

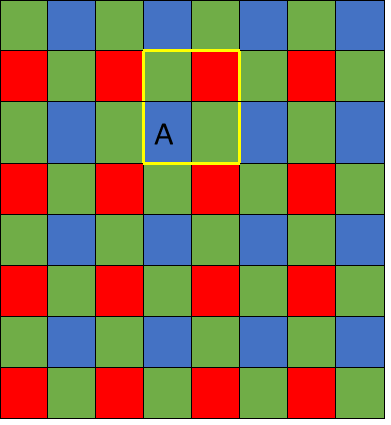

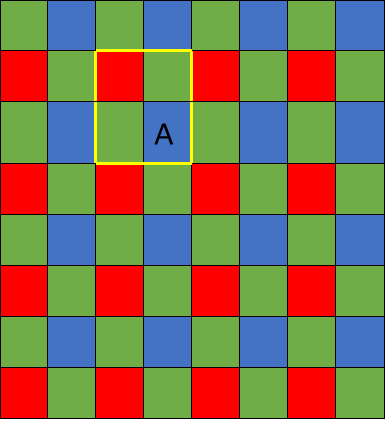

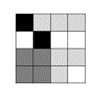

Um fato interessante é que os elementos fotossensíveis da grande maioria das câmeras fotográficas detectam apenas intensidade luminosa e não cores. Para colorir uma foto podem ser usados vários artifícios nos sensores, sendo o mais comum o filtro Bayer. Cada pixel recebe um filtro vermelho, verde ou azul.  A disposição normal possui dois filtros verdes para cada azul ou vermelho. Isto é pela diferente sensibilidade que nossa visão tem para essas cores. Na figura vemos um modelo de sensor usando o filtro Bayer. Se você editar uma foto em formato RAW, verá uma foto esverdeada. A maioria dos editores de fotos, e mesmo as câmeras, nos mostram a foto já com esse mosaico de cores convertido para as cores aproximadas da cena fotografada. Com a combinação de vermelho (Red), verde (Green) e azul (Blue), conseguimos gerar praticamente boa parte das cores possíveis. Existem vários algoritmos para fazer essa conversão. Note que para cada pixel temos uma cor bem determinada, mas as duas outras faltantes. Os algoritmos tentam determinar essas duas cores faltantes. Isto pode ser feito agrupando-se 4 pixels vizinhos de formas diferentes. Note na figura o pixel “A” e as formas diferentes de se combinar os valores RGB (vermelho, verde e azul).

A disposição normal possui dois filtros verdes para cada azul ou vermelho. Isto é pela diferente sensibilidade que nossa visão tem para essas cores. Na figura vemos um modelo de sensor usando o filtro Bayer. Se você editar uma foto em formato RAW, verá uma foto esverdeada. A maioria dos editores de fotos, e mesmo as câmeras, nos mostram a foto já com esse mosaico de cores convertido para as cores aproximadas da cena fotografada. Com a combinação de vermelho (Red), verde (Green) e azul (Blue), conseguimos gerar praticamente boa parte das cores possíveis. Existem vários algoritmos para fazer essa conversão. Note que para cada pixel temos uma cor bem determinada, mas as duas outras faltantes. Os algoritmos tentam determinar essas duas cores faltantes. Isto pode ser feito agrupando-se 4 pixels vizinhos de formas diferentes. Note na figura o pixel “A” e as formas diferentes de se combinar os valores RGB (vermelho, verde e azul).

Esse método supõe que as cores contíguas são similares. Isto não é verdade nas arestas de objetos, por exemplo, e o algoritmo faz as correções adequadas. Este assunto foge do escopo deste artigo e do meu conhecimento também. Só pode ser interessante saber que muitos softwares de edição de fotos possibilitam usar vários métodos diferentes e você poderá escolher o mais adequado para sua situação. Por exemplo, os métodos mais usados para fotos de paisagens e retratos não são adequados para fotos de estrelas. Elas aparecerão meio quadradas...

Tudo isto só é possível graças a espantosa capacidade de processamento dos processadores de sua câmera ou celular. Você tira uma foto, ela é armazenada em formato RAW e, para ser mostrada no visor, será convertida como explicado acima para que a veja colorida de forma natural. Se escolher armazenar em formato JPEG, o processador também terá que fazer essa conversão. E tudo é feito em um piscar de olhos.

Vemos ao lado uma foto RAW onde o mosaico não foi desfeito. Softwares de edição de fotos praticamente sempre farão essa conversão, pois não faz sentido ver a foto esverdeada como mostrado na figura.

Vemos ao lado uma foto RAW onde o mosaico não foi desfeito. Softwares de edição de fotos praticamente sempre farão essa conversão, pois não faz sentido ver a foto esverdeada como mostrado na figura.

A seguir vemos um pedaço ampliado da foto sem a transformação.

A foto resultante da transformação é mostrada abaixo. É a foto de um tecido de cadeira.

Um software que permite experimentar com este processo de desmontagem do mosaico criado pela câmera é o RawTherapee. Ele possibilita a utilização de vários métodos.

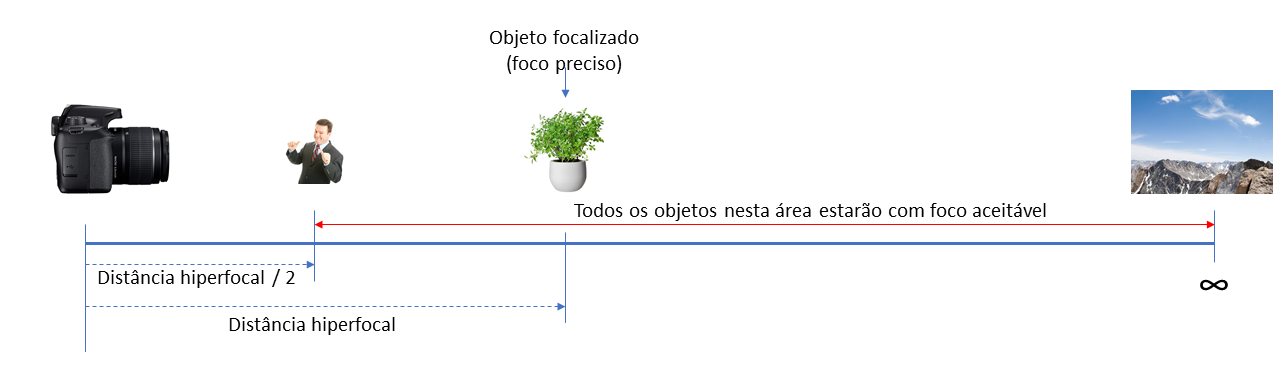

Distância hiperfocal

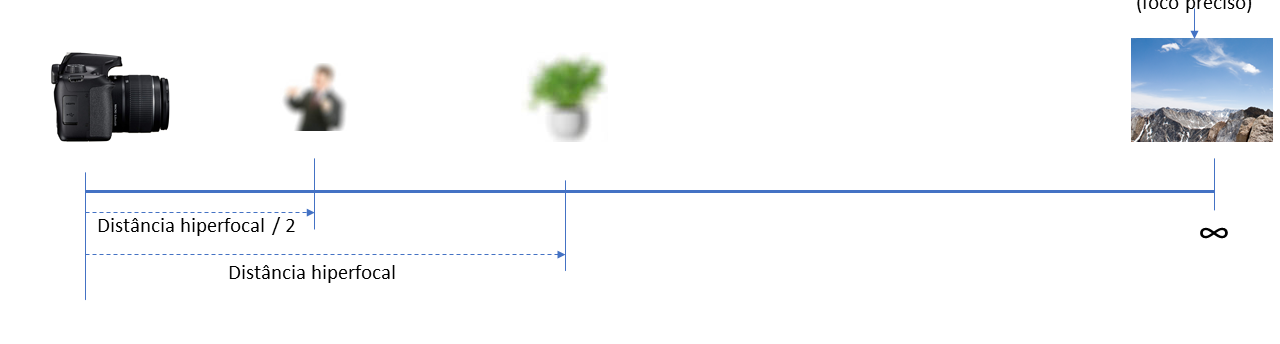

O que vimos até agora é algo que deve ser entendido e usado sempre que você for tirar uma fotografia. O assunto, distância hiperfocal, é importante que seja entendido e que você tenha em mente, mas não deve ser uma preocupação que estrague o prazer de tirar fotos, uma vez que obrigaria a utilização de uma tabela ou um aplicativo para calculá-la. Este conceito aplica-se quando você quer tirar fotografia de uma paisagem onde alguns elementos em primeiro plano bem como os elementos em segundo plano estejam em foco. Se você focalizar no elemento em primeiro plano, provavelmente o segundo plano não estará em foco. Se você, por outro lado, focalizar nos elementos no segundo plano (montanhas, por exemplo), os elementos no primeiro plano não estarão em foco.

Toda lente possui uma distância, para cada abertura do diafragma, que fará com que, se você focar em um elemento nesse local, tenha a maior profundidade de campo possível. É importante salientar que o elemento focalizado não necessita ser o elemento principal da foto. Por exemplo, você pode estabelecer o foco em uma planta que esteja na distância hiperfocal. Tudo o que estiver entre a metade da distância entre a planta e a câmera até o infinito estará em foco aceitável.

Por outro lado, se você focalizasse as montanhas no horizonte, a pessoa e objetos mais próximos da câmera ficariam desfocados.

Memorize qual a distância hiperfocal da abertura considerada “sweet spot” de sua lente. Esta informação pode ser útil em algumas situações.

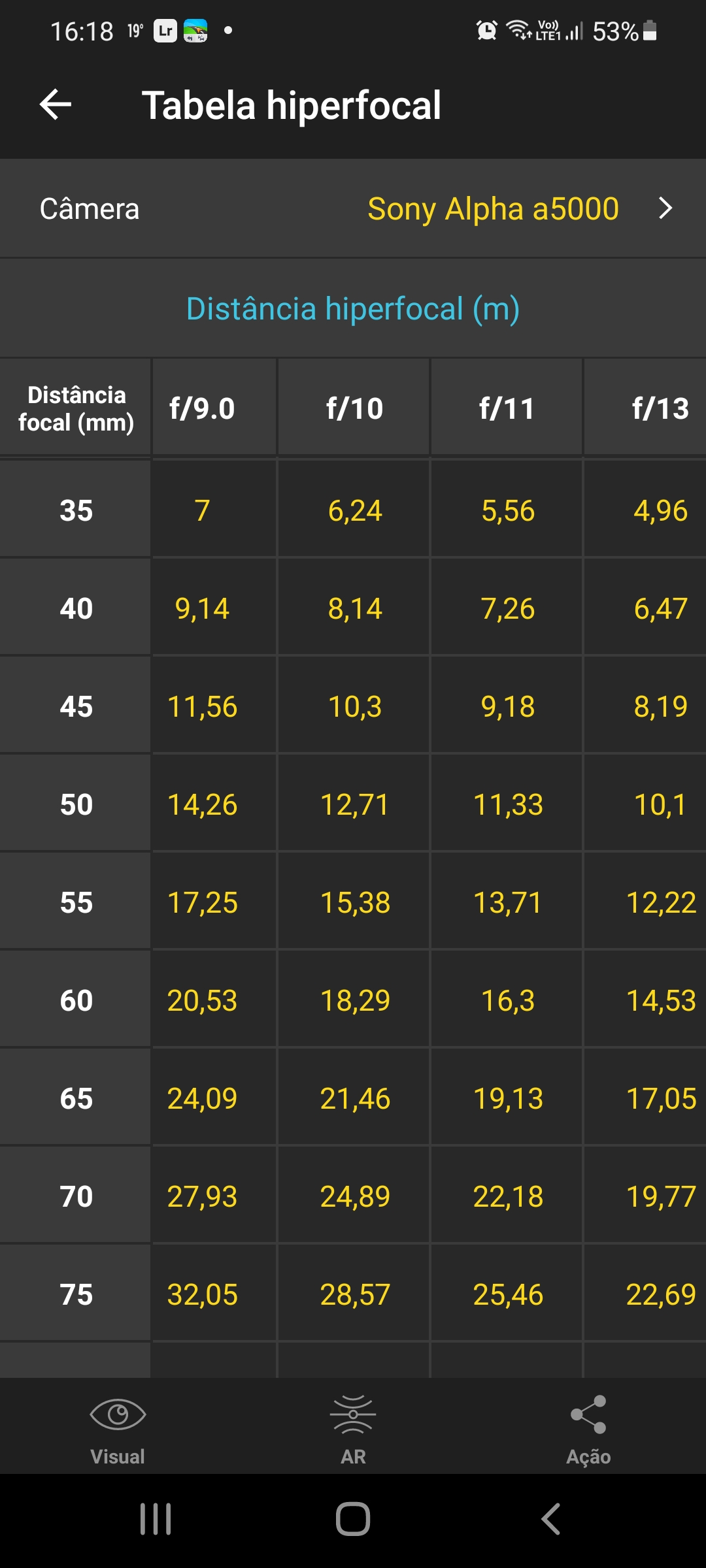

Veja, na tabela ao lado, que para a câmera Sony a5000, se usarmos a lente com distância focal 35mm, teremos, com uma abertura f/11, uma distância hiperfocal de 5,56m. Ou seja, se focalizarmos um objeto a essa distância da câmera, tudo o que estiver a uma distância de 2,78m até o infinito, estará com foco aceitável. Esta tabela foi obtida com a aplicação PhotoPils em um celular Android.

Veja, na tabela ao lado, que para a câmera Sony a5000, se usarmos a lente com distância focal 35mm, teremos, com uma abertura f/11, uma distância hiperfocal de 5,56m. Ou seja, se focalizarmos um objeto a essa distância da câmera, tudo o que estiver a uma distância de 2,78m até o infinito, estará com foco aceitável. Esta tabela foi obtida com a aplicação PhotoPils em um celular Android.

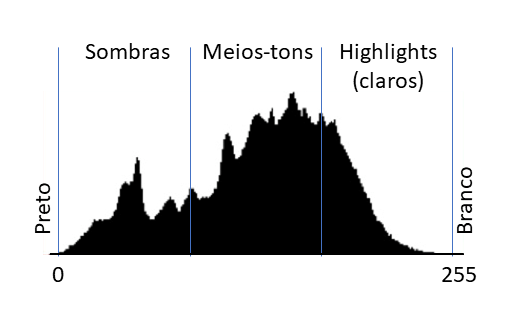

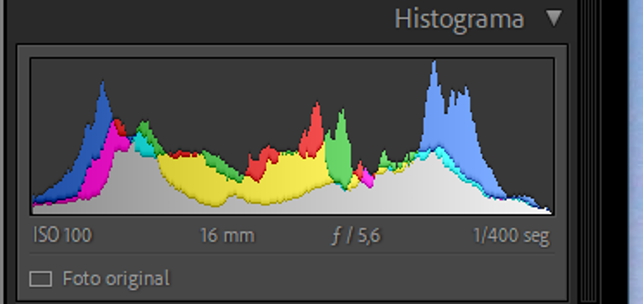

Histograma

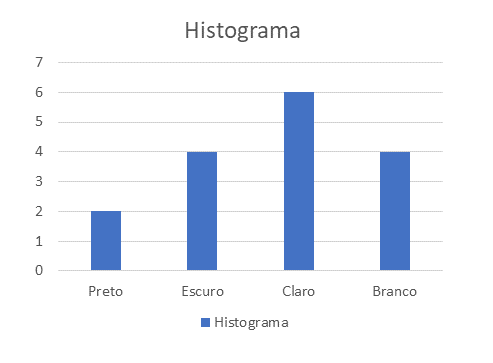

Uma ferramenta extremamente útil que muitas câmeras e softwares de edição de fotos oferecem é o histograma. Um histograma é um gráfico que apresenta alguma grandeza sendo estudada no eixo X e a frequência de cada valor do eixo X mostrada no eixo Y. Em fotografia, embora você possa ter histogramas para as cores vermelho, verde e azul, normalmente usa-se histograma para escala de cinzas. A escala de luminosidade vai do preto ao branco passando por todas as tonalidades de cinza. Vamos montar um histograma simplificado para entender o conceito.

Cada pixel (Picture element) de uma imagem corresponde a um elemento de captura de luz no sensor da câmera fotográfica. A câmera da Sony a6500 possui um sensor de 24,3Mpixels, ou seja, possui 24.300.000 pixels. No nosso exemplo, vamos imaginar um sensor fictício de 16 pixels apenas (isso mesmo dezesseis pixels).

Cada pixel (Picture element) de uma imagem corresponde a um elemento de captura de luz no sensor da câmera fotográfica. A câmera da Sony a6500 possui um sensor de 24,3Mpixels, ou seja, possui 24.300.000 pixels. No nosso exemplo, vamos imaginar um sensor fictício de 16 pixels apenas (isso mesmo dezesseis pixels).

Veja que na imagem fictícia de nosso sensor temos pixels com luminosidade variando do preto ao branco passando por dois tons de cinza.

Se montarmos um gráfico de barras colocando o número de pixels pretos (2), cinza escuro (4), cinza claro (6) e branco (4) teremos o histograma da figura abaixo.

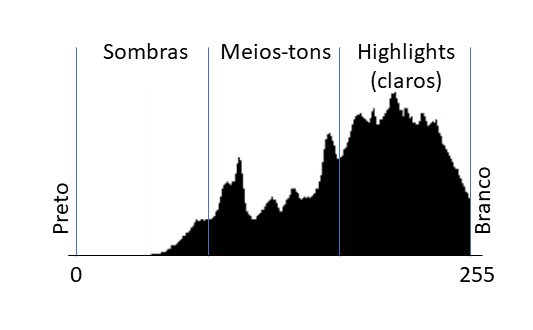

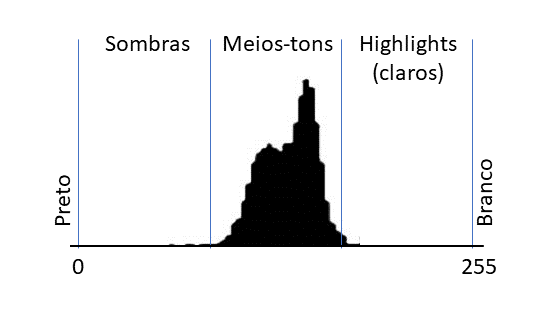

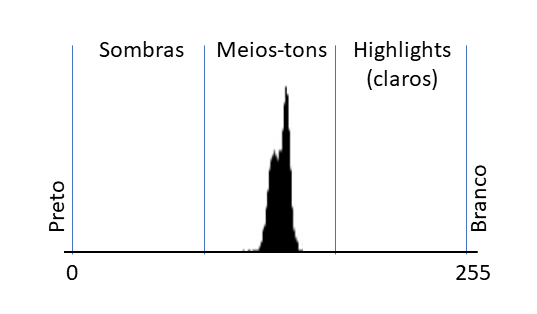

Um histograma em uma máquina fotográfica mostra a frequência para 256 níveis de luminosidade variando do preto (0) ao branco (255).

Já no histograma seguinte, a imagem está subexposta. Os detalhes de áreas escuras (sombras) foram perdidos e não podem ser recuperados. Note que a frequência próxima do preto é alta e interrompida bruscamente.

No próximo histograma, o corte (clipping) ocorre nos tons claros (highlights). Note que a frequência próxima do branco é alta e interrompida bruscamente.

Nem sempre é possível conseguir-se um histograma com a luminosidade bem distribuída, pois isto depende da cena. Uma fotografia tirada de uma paisagem com neve, obviamente, possuirá uma grande concentração na área de highlights do histograma. É, no entanto, fundamental evitar-se o clipping para que detalhes não sejam perdidos.

Ao tirar uma foto, deixe sempre o histograma visível no display ou viewfinder de sua câmera. Desta forma, você poderá regular a exposição de modo a evitar clippings das sombras ou dos highlights. Além de alterar a abertura e a velocidade do obturador, você poderá utilizar o controle de compensação de exposição de sua máquina. Ele possui um ícone como o mostrado na figura ![]() . Ao aumentar o diminuir o valor de exposição (EV – exposure value) você verá o histograma se deslocar de um lado ao outro. Escolha o EV que minimiza ou elimina clipping. Lembre-se que é melhor ter uma foto um pouco superexposta, mas sem clipping. Ao mover o botão de compensação de exposição você verá um indicador semelhante a este

. Ao aumentar o diminuir o valor de exposição (EV – exposure value) você verá o histograma se deslocar de um lado ao outro. Escolha o EV que minimiza ou elimina clipping. Lembre-se que é melhor ter uma foto um pouco superexposta, mas sem clipping. Ao mover o botão de compensação de exposição você verá um indicador semelhante a este ![]() . Neste exemplo, a compensação de exposição é zero. Para a esquerda escurece-se a imagem, para a direita clareia-se. Ou, em outras palavras, para a esquerda, desloca-se o histograma para a esquerda, diminuindo os highlights e eventuais clippings. Para a direita desloca-se o histograma para a direita, diminuindo as sombras e eventuais clippings de sombras.

. Neste exemplo, a compensação de exposição é zero. Para a esquerda escurece-se a imagem, para a direita clareia-se. Ou, em outras palavras, para a esquerda, desloca-se o histograma para a esquerda, diminuindo os highlights e eventuais clippings. Para a direita desloca-se o histograma para a direita, diminuindo as sombras e eventuais clippings de sombras.

Nos histogramas mostrados você notou que existem áreas de sombras, highlights e de meios-tons. Se você tiver a foto em formato RAW, poderá, com um software de edição, alterar a luminosidade de forma independente dessas áreas de forma perfeita. Se você tiver a foto apenas em JPG, também poderá fazer este tipo de ajuste, mas não será tão perfeito.

Outro ajuste que pode ser feito com softwares de edição é o contraste. Um histograma muito concentrado ao redor de um ponto representa uma foto com pouco contraste. Aumentar o contraste significa “afastar” pontos escuros em direção ao preto e pontos claros em direção ao branco.

Pelo explicado vimos a importância do histograma. Ele é muito útil na hora de tirar uma foto e também na hora da edição.

Cabe ressaltar que fotografia é uma arte e, como tal, não dá para estabelecer regras. Por exemplo, embora evitar o clipping seja, muitas vezes, importante, em algumas situações ele pode ser desejável. Fotos de florestas com sombras sem mostrar detalhes pode ser interessante. É mais comum ser útil clipping nas sombras do que nas áreas claras(highlights) da foto.

Softwares de edição podem mostrar histogramas para as cores vermelha, verde e azul (RGB – Red, Green e Blue).

À esquerda vemos um histograma colorido do software de edição de fotos Lightroom® da Adobe™. Note que, além das cores vermelho, verde e azul (que quase não aparece) temos outras cores. Elas são mostradas quando há superposição de cores. Amarelo é mostrado quando vermelho e verde se sobrepõem, magenta quando vermelho e azul se sobrepõem e ciano quando verde e azul se sobrepõem. Algumas vezes você pode ter histogramas separados para cada cor: vermelho, verde e azul. Os conceitos são os mesmos discutidos anteriormente, mas aplicados a cada cor individualmente.

À esquerda vemos um histograma colorido do software de edição de fotos Lightroom® da Adobe™. Note que, além das cores vermelho, verde e azul (que quase não aparece) temos outras cores. Elas são mostradas quando há superposição de cores. Amarelo é mostrado quando vermelho e verde se sobrepõem, magenta quando vermelho e azul se sobrepõem e ciano quando verde e azul se sobrepõem. Algumas vezes você pode ter histogramas separados para cada cor: vermelho, verde e azul. Os conceitos são os mesmos discutidos anteriormente, mas aplicados a cada cor individualmente.

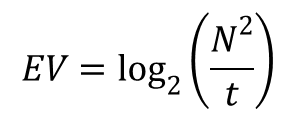

Exposure Value (EV)

Aqui um conceito que você não precisa memorizar, mas vale a pena entender apenas porque falamos acima sobre o Exposure Value Compensation. Exposure Value, ou simplesmente EV é um número que combina a abertura e a velocidade do obturador. Ele é calculado pela fórmula  onde N é o f stop e t é o tempo de abertura do obturador. Não se preocupe em entender a fórmula! Apenas entenda que que o EV é um número que quanto maior, mais iluminada é a cena e, portanto, menor a abertura e/ou tempo de exposição. Cada unidade aumentada no EV, você diminuirá pela metade a quantidade de luz que chegará ao sensor. Inversamente, cada unidade que você diminua no EV fará com que o dobro da quantidade de luz chegue ao sensor. Esta fórmula é válida para ISO 100. Para ISO maior basta lembrar que cada vez que o ISO dobra deve-se reduzir pela metade a quantidade de luz (aumentar o f stop, por exemplo, se era f/5.6, passar para f/8.0 ou diminuir pela metade o tempo de exposição, se era 1/200 passá-lo para 1/400).

onde N é o f stop e t é o tempo de abertura do obturador. Não se preocupe em entender a fórmula! Apenas entenda que que o EV é um número que quanto maior, mais iluminada é a cena e, portanto, menor a abertura e/ou tempo de exposição. Cada unidade aumentada no EV, você diminuirá pela metade a quantidade de luz que chegará ao sensor. Inversamente, cada unidade que você diminua no EV fará com que o dobro da quantidade de luz chegue ao sensor. Esta fórmula é válida para ISO 100. Para ISO maior basta lembrar que cada vez que o ISO dobra deve-se reduzir pela metade a quantidade de luz (aumentar o f stop, por exemplo, se era f/5.6, passar para f/8.0 ou diminuir pela metade o tempo de exposição, se era 1/200 passá-lo para 1/400).

Já mostramos que uma foto pode ser tirada com várias combinações de abertura e tempo de abertura do obturador com a mesma quantidade de luz atingindo o sensor. Na realidade, todas as fotos foram tiradas com o mesmo EV. Em outras palavras, quando determinamos a abertura e velocidade do obturador que produza a luminosidade correta para a foto, estamos determinando o EV correto para aquela cena. O botão Exposure Value Compensation selecionando +1EV fará com que a foto fique superexposta, portanto, mais clara. Já um valor de -1EV fará com que a foto fique subexposta, portanto mais escura.

Lembrando que a medição de luz de uma câmera pode ser feita de diversas formas: em um ponto central, média de vários pontos, média ponderada de vários pontos e ponto central etc. Nenhuma forma de medição garantirá que TODOS os pontos da foto sejam expostos corretamente. Dessa forma, algumas áreas da foto, por exemplo, mesmo com o EV correto, podem estar sobre ou superexpostas. Para evitar o clipping dessas áreas, usa-se o Exposure Value Compensation ![]() . A foto, como um todo, pode ficar um pouco mais clara ou escura, mas sem clipping. Softwares de edição de fotos podem ser utilizados, posteriormente, para corrigir a foto, se necessário. Se houvesse clipping, não seria possível corrigi-la.

. A foto, como um todo, pode ficar um pouco mais clara ou escura, mas sem clipping. Softwares de edição de fotos podem ser utilizados, posteriormente, para corrigir a foto, se necessário. Se houvesse clipping, não seria possível corrigi-la.

Muitas câmeras possuem formas de mostrar no display ou no viewfinder áreas onde estão ocorrendo clipping (no caso da figura, a área achuriada). Alterando o exposure value compensation vê-se a diminuição ou aumento dessas áreas.

Muitas câmeras possuem formas de mostrar no display ou no viewfinder áreas onde estão ocorrendo clipping (no caso da figura, a área achuriada). Alterando o exposure value compensation vê-se a diminuição ou aumento dessas áreas.

Algumas câmeras permitem variação no exposure value compensation entre -2 e +2. Câmeras melhores, de -5 a +5.

Aspect ratio

Vimos que o sensor de uma câmera full frame tem dimensões 36mm por 24mm o que daria uma proporção 3 x 2. O sensor cropped da câmera a6500 da Sony possui um sensor de dimensões 23,5mm por 15,6mm que resulta em uma proporção próxima a 3 x 2 também. É possível, no entanto tirar-se fotos em outras proporções. Uma proporção de 16 x 9 é usada, por exemplo, quando o objetivo é criar fotos para serem vistas em televisores ou mesmo celulares. Na realidade, a foto é tirada na proporção 3 x 2, mas mostrada “cortada” para a proporção 16 x 9. Se a foto tiver sido salva em formato RAW, em um software de edição de fotos é possível recuperar-se o formato 3 x 2. Alguns fotógrafos preferem tirar a foto utilizando toda a área do sensor, ou seja, em formato 3 x 2 e, depois, no software de edição de fotos fazer o corte.

Na figura ao lado vemos a imagem capturada pelo sensor e, sombreada, a parte da imagem que seria “perdida” se ela for salva com o aspecto 16 x 9. Em uma câmera com 24,3 Mpixels, no formato 16 x 9 utilizaríamos apenas 20,5 Mpixels.